Как работают системы активной безопасности

Перечень систем активной безопасности современного автомобиля включает множество позиций, не ограничиваясь привычными ABS и ESP. Разберемся, как они работают на примере автомобилей Nissan

Станислав Шустицкий

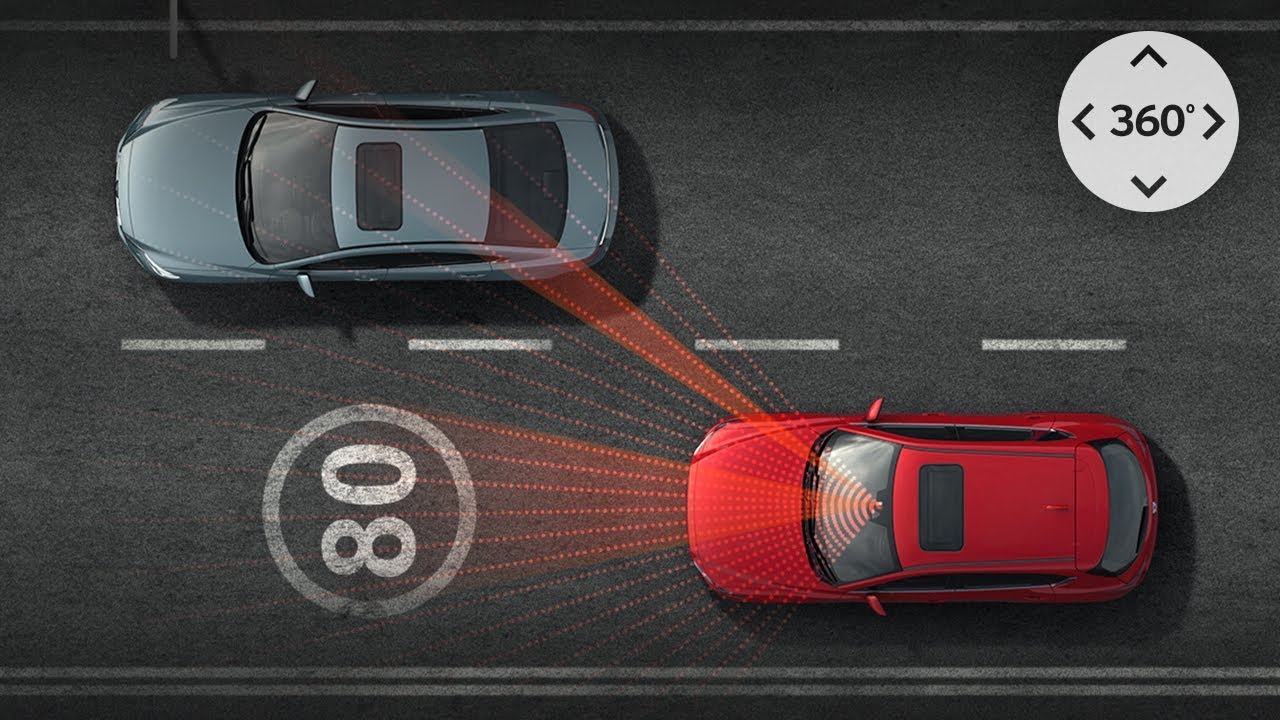

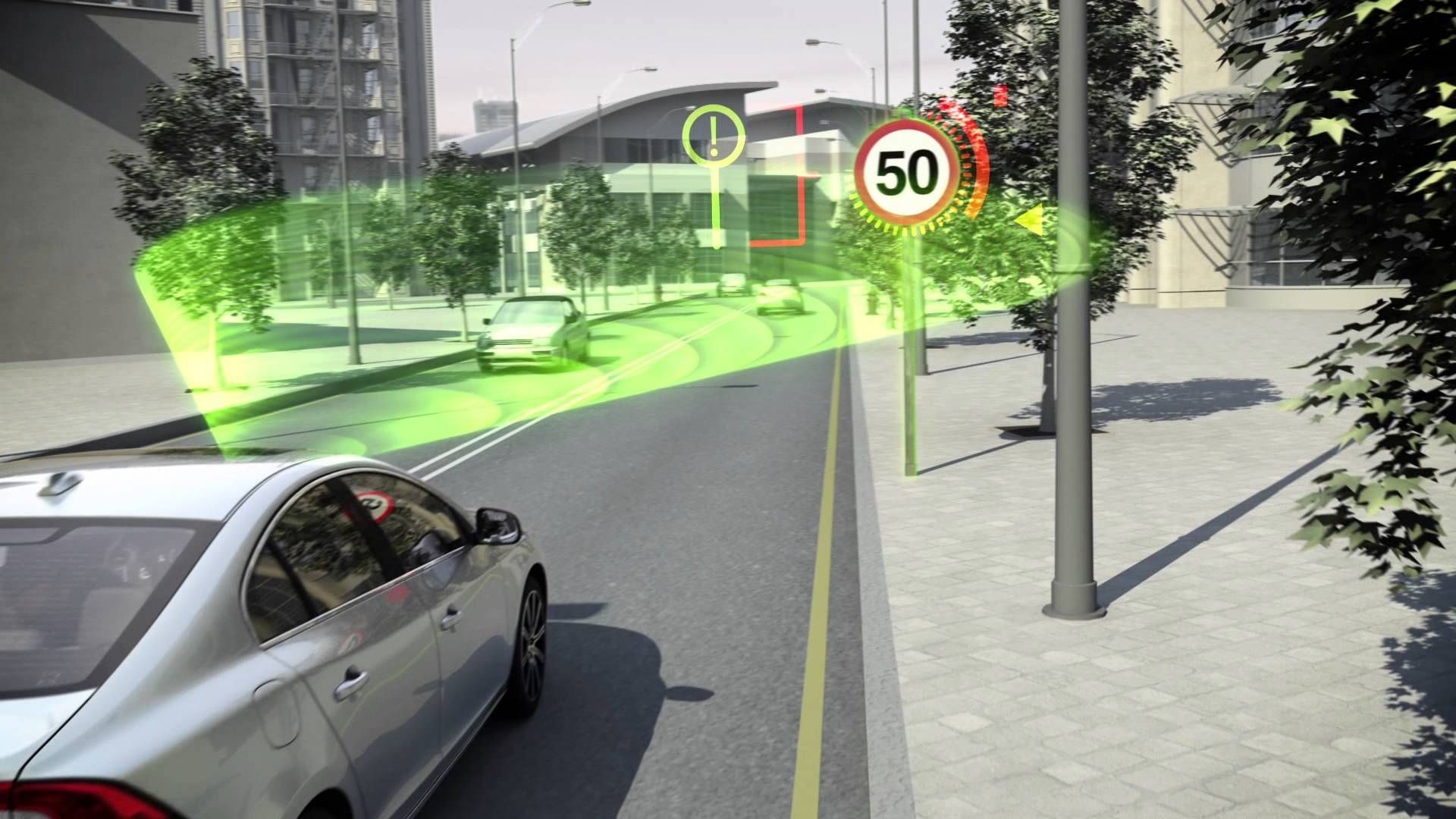

Начать стоит с системы курсовой устойчивости (или, как ее еще называют, системы динамической стабилизации), которая для автомобилей Nissan входит в перечень стандартного оборудования. На самом деле ESP (Electronic Stability Program) — это целый комплекс, куда входят и модуль антиблокировочной системы тормозов (ABS), и система распределения тормозных усилий (EBD). Внешние параметры, к которым относятся положение автомобиля относительно дороги, степень сцепления колес с дорогой и некоторые действия водителя, отслеживаются датчиками. Датчики фиксируют угол поворота рулевого колеса, давление в системе тормозов, частоту вращения колес, величину продольного и поперечного ускорения, а также угловую скорость автомобиля. Сигналы с датчиков анализируются блоком управления ESP, который перенаправляет информацию подконтрольным системам, в числе которых не только ABS и EBD, но и блоки управления двигателем и коробкой передач. За долю секунды ESP успевает проанализировать соответствие действий водителя реальной ситуации и в случае «дисгармонии» включиться в работу. Система также определяет оптимальный вариант выхода из аварийной ситуации: изменение крутящего момента двигателя, подтормаживание соответствующих колес или комплекс мер, включающий оба варианта.

Внешние параметры, к которым относятся положение автомобиля относительно дороги, степень сцепления колес с дорогой и некоторые действия водителя, отслеживаются датчиками. Датчики фиксируют угол поворота рулевого колеса, давление в системе тормозов, частоту вращения колес, величину продольного и поперечного ускорения, а также угловую скорость автомобиля. Сигналы с датчиков анализируются блоком управления ESP, который перенаправляет информацию подконтрольным системам, в числе которых не только ABS и EBD, но и блоки управления двигателем и коробкой передач. За долю секунды ESP успевает проанализировать соответствие действий водителя реальной ситуации и в случае «дисгармонии» включиться в работу. Система также определяет оптимальный вариант выхода из аварийной ситуации: изменение крутящего момента двигателя, подтормаживание соответствующих колес или комплекс мер, включающий оба варианта.

Например, при прохождении поворота у автомобиля развивается недостаточная поворачиваемость (траектория автомобиля стремится наружу поворота).

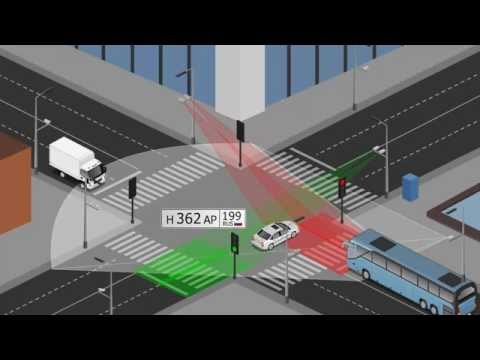

Так, схематично, работает система активного торможения двигателем

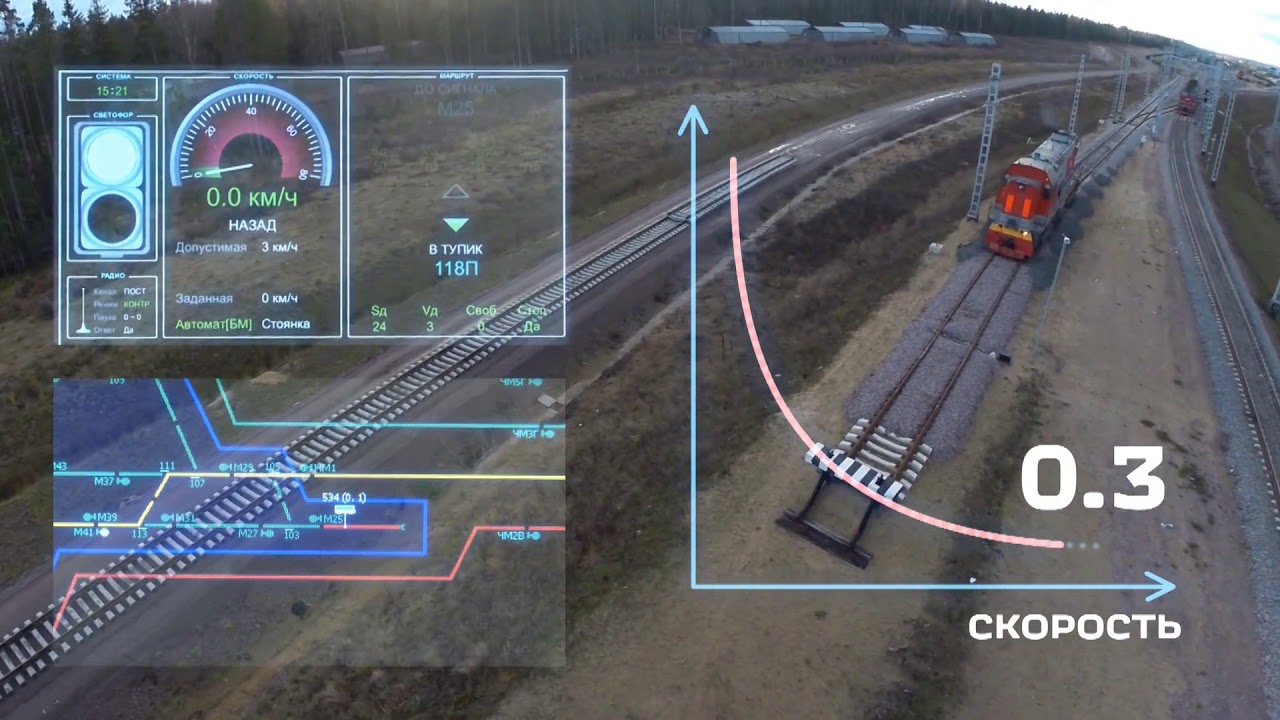

В автомобилях Nissan с вариатором в трансмиссии также может использоваться система ARC (Active Ride Control), гасящая продольные колебания кузова на неровностях дороги. Опция нелишняя, так как при раскачке автомобиля на дорожных волнах значительно снижается эффективность сцепления колес с дорогой. Система распознает особенности дорожного покрытия, при наличии волн регулирует крутящий момент двигателя (для моторов объемом 2 литра) и одновременно подтормаживает соответствующие колеса, устраняя саму вероятность раскачки.

Система Active Ride Control гасит продольные колебания кузова автомобиля при движении по неровной дороге

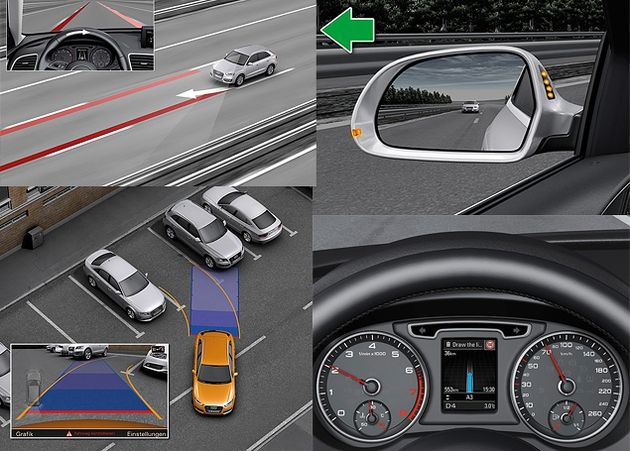

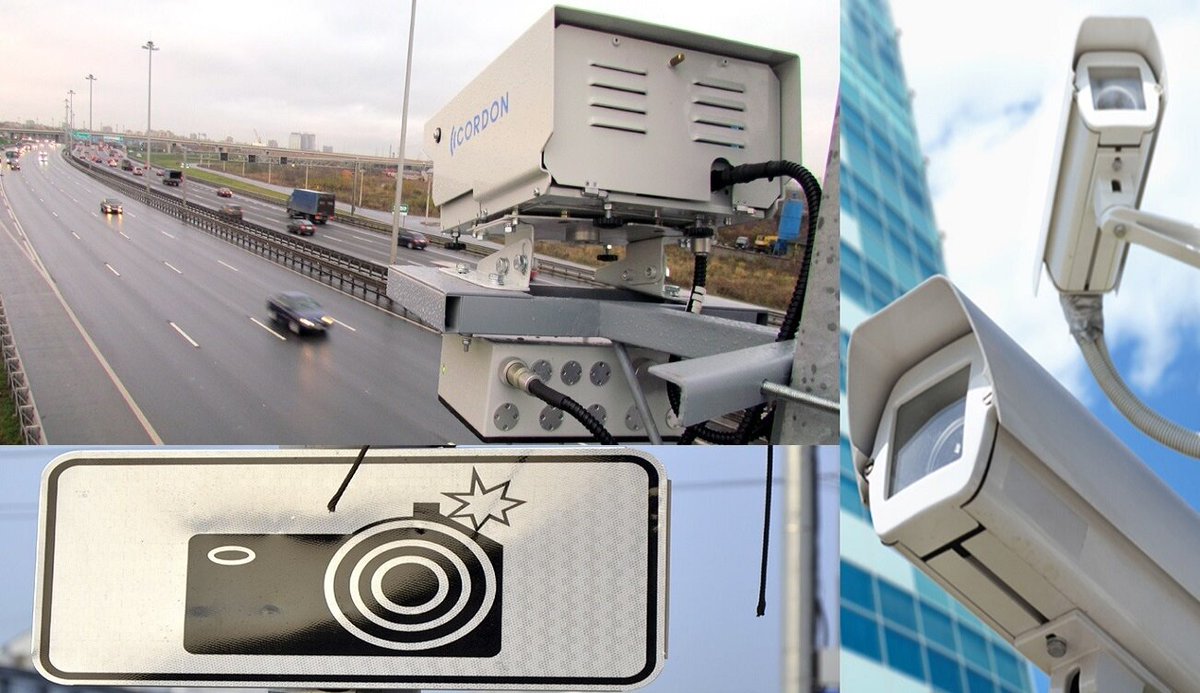

Еще целый ряд систем помощи водителю сегодня входят в список тех опций, которые хотели бы иметь на вооружении многие владельцы автомобилей. И они действительно помогают значительно снизить риск возникновения аварийных ситуаций. Если вернуться к Nissan, то разработчики компании постоянно работают над внедрением новых и усовершенствованием уже применяемых систем активной безопасности и систем помощи водителю. Вот, к примеру, усовершенствованная система мониторинга слепых зон Blind Spot Warning, работающая при скорости движения свыше 32 км/ч. Камера заднего вида отслеживает появление транспортного средства в радиусе трех метров позади вашего автомобиля, и система предупреждает вас об этом включением светового индикатора на передней стойке.

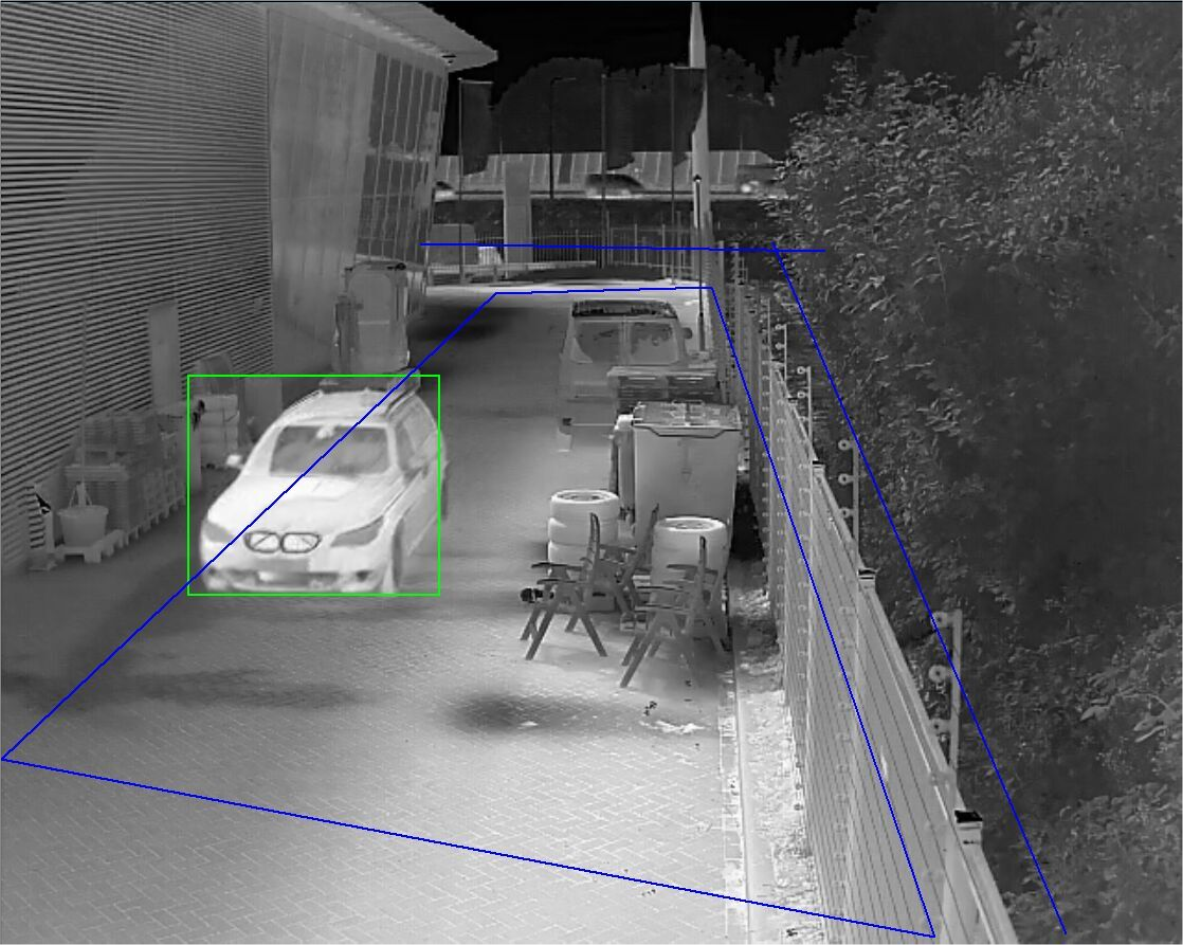

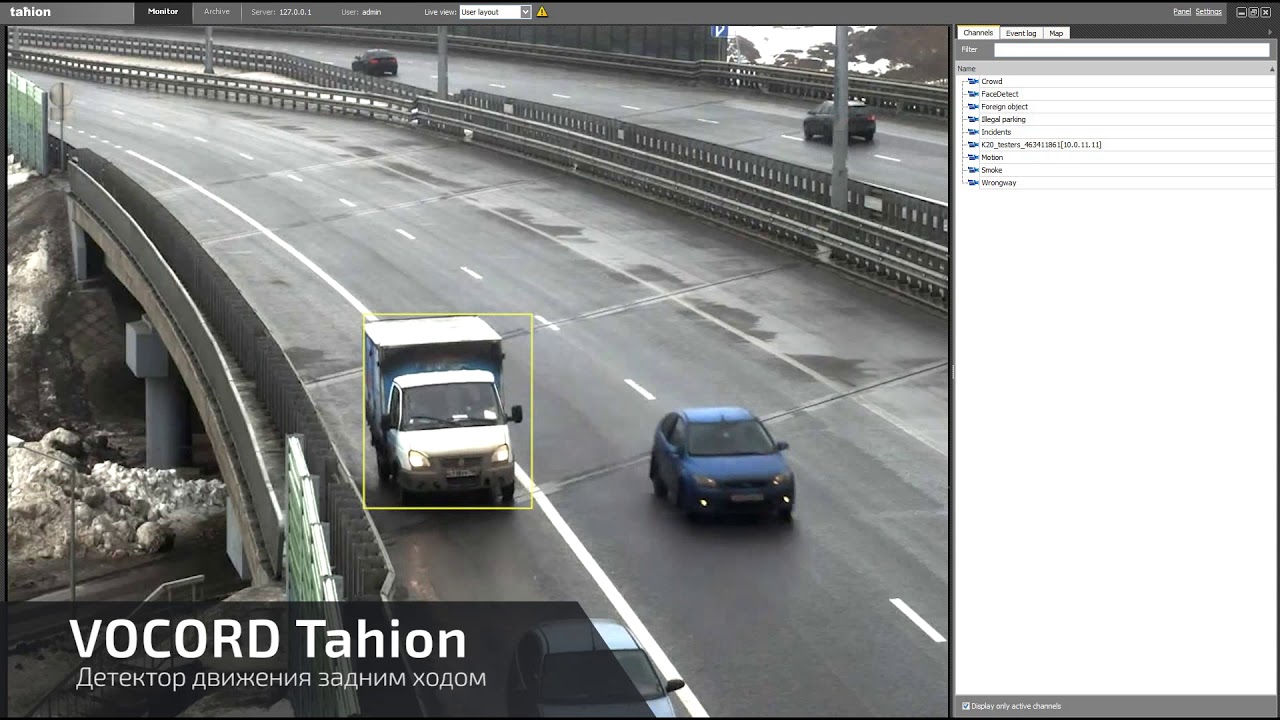

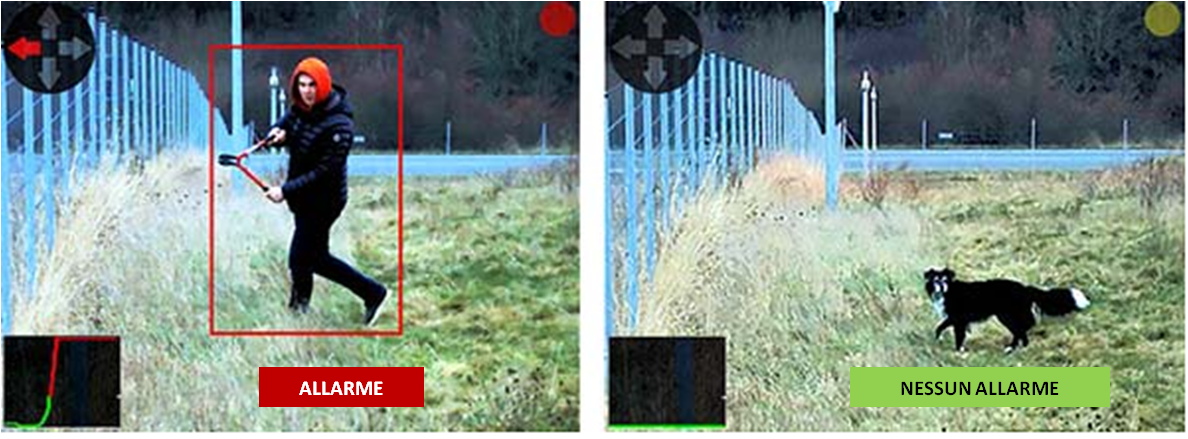

С помощью расположенной сзади камеры система MOD мониторит пространство, предупреждая о появлении транспортных средств в соседних рядах

Не заметили сигнала о наличии другого транспортного средства в «слепой» зоне и решили перестроиться в соседний ряд? Система BSW еще раз предупредит вас об опасности, но на этот раз двукратным звуковым сигналом. Пропускать пешеходов, переходящих проезжую часть по переходу, постепенно становится у российских водителей доброй привычкой. Важно того самого пешехода увидеть, особенно в темное время суток. В этом водителям автомобилей Nissan поможет система распознавания движущихся объектов Moving Object Detection. При обнаружении пешехода в зоне работы системы MOD подается звуковой сигнал, а на экране, расположенном на центральной консоли, высвечивается зона, на которой обнаружен пешеход. С помощью передней камеры осуществляется работа системы Lane Departure Warning, контролирующая движение в рамках занимаемой полосы. Во время движения автомобиля со скоростью свыше 60 км/ч при пересечении линии разметки без включения указателя поворота подается звуковой сигнал и включается индикатор на панели приборов.

Система Lane Departure Warning с помощью камеры контролирует движение в рамках занимаемой полосы

Еще одна опция, используемая в автомобилях Nissan, — это система контроля усталости водителя (Driver Attention Support). В начале движения система анализирует манеру езды водителя и, «заметив» впоследствии изменение в стиле вождения, с помощью аудио- или визуального предупреждения напоминает о необходимости сделать перерыв в нахождении за рулем.

В работе электронной системы стабилизации Nissan задействованы все необходимые компоненты: и Active Ride Control, и Active Engine Brake, и Active Trace Control…

О каждой из этих систем с точки зрения технологий и примененных в них инноваций можно рассказать более подробно, и оно этого стоит. Но вышло так, что затронутая в одном из предыдущих номеров нашего журнала тема о ряде преимуществ, касающихся владения автомобилями Nissan, получила продолжение и в этой, казалось бы, чисто технической истории. «Оценивая стоимость владения новым автомобилем, мы часто «зрим в корень», стараясь тщательно учесть очевидные, на первый взгляд, расходы», — именно так начиналась предыдущая статья, касавшаяся стоимости владения автомобилями Nissan.

Система Active Trace Control может работать в любой точке поворота, если определит, что автомобиль уходит с оптимальной траектории

Техник работал много лет с Benetton и команде наследования Renault. В 2009 году британец был впутан в скандал Сингапура 2008. Когда афера раскрылась, он вынужден был покинуть команду, и договорился с FIA о том, что он сможет работать в Формуле- 1 только с 2013 года.

Техник работал много лет с Benetton и команде наследования Renault. В 2009 году британец был впутан в скандал Сингапура 2008. Когда афера раскрылась, он вынужден был покинуть команду, и договорился с FIA о том, что он сможет работать в Формуле- 1 только с 2013 года.Однако, договорённость была таковой, что Симондс может выступать только в роли консультанта. «Есть все еще много вещей, которые я хотел бы сделать. Теперь я работаю как консультант и делаю многое в гоночном спорте, но также и в других областях. Я все еще люблю технический аспект Формулы -1».

Редакция рекомендует:

Хочу получать самые интересные статьи

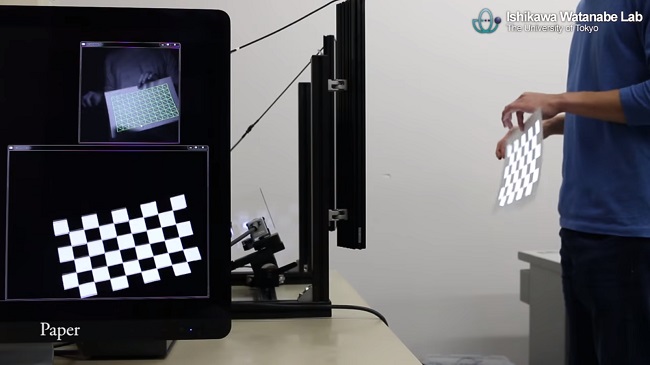

Обнаружение и распознавание объектов с камеры в ROS с помощью пакета find_object_2d / Хабр

Одним из преимуществ Robot Operating System (ROS) является то, что у него есть множество пакетов, которые можно использовать повторно в наших приложениях..png) В нашем случае мы хотим внедрить систему распознавания и обнаружения объектов. Пакет find_object_2d реализует SURF, SIFT, ORB, FAST и BRIEF детекторы функций и дескрипторы для обнаружения объектов. Используя графический интерфейс, предоставляемый этим пакетом, мы можем отметить объекты, которые мы хотим обнаружить, и сохранить их для будущего обнаружения. Узел детектора будет обнаруживать объекты в изображениях камеры и публиковать детали объекта через тему. Используя 3D-датчик, он может оценить глубину и ориентацию объекта.

В нашем случае мы хотим внедрить систему распознавания и обнаружения объектов. Пакет find_object_2d реализует SURF, SIFT, ORB, FAST и BRIEF детекторы функций и дескрипторы для обнаружения объектов. Используя графический интерфейс, предоставляемый этим пакетом, мы можем отметить объекты, которые мы хотим обнаружить, и сохранить их для будущего обнаружения. Узел детектора будет обнаруживать объекты в изображениях камеры и публиковать детали объекта через тему. Используя 3D-датчик, он может оценить глубину и ориентацию объекта.

В конце статьи, видео тестирования на примере алгоритмов ORB и SIFT.

Установка find_object_2d

Установка этого пакета довольно проста. Вот команда, чтобы установить его на Ubuntu 16.04 и ROS Kinetic:

$ sudo apt-get install ros-kinetic-find-object-2dУстановка из исходного кода

Переключитесь в рабочее пространство ROS:

$ cd ~/catkin_ws/srcСкопируйте исходный код в папку src:

$ git clone https://github.

com/introlab/find-object.git

src/find_object_2dСоздайте рабочее пространство:

$ catkin_makeЗапуск узлов find_object_2d с помощью веб-камер

Ниже приведена процедура запуска узлов детектора для веб-камеры. Если мы хотим обнаружить объект с помощью веб-камеры, сначала необходимо установить пакет usb_cam(см предыдущую статью).

1. Запусти roscore:

$ roscore2.1 Подключите USB-камеру к компьютеру и запустите драйвер ROS usb_cam:

$ roslaunch usb_cam usb_cam-test.launchЭто запустит драйвер ROS для USB веб-камер, и вы сможете посмотреть темы в этом драйвере, используя команду rostopic list. Список тем в драйвере показан здесь:

Темы, публикуемые из драйвера камеры

2.2 Альтернативный вариант трансляции видео с камеры через uvc_camera:

$ rosrun uvc_camera uvc_camera_node 3. Из списка тем мы собираемся использовать тему необработанного изображения с камеры, которая публикуется в теме /usb_cam/image_raw. Если вы получаете эту тему, то следующим шагом будет запуск узла обнаружения объекта. Следующая команда запустит узел обнаружения объекта:

Если вы получаете эту тему, то следующим шагом будет запуск узла обнаружения объекта. Следующая команда запустит узел обнаружения объекта:

$ rosrun find_object_2d find_object_2d image:=/usb_cam/image_rawЭта команда откроет окно детектирования объекта, в котором мы видим канал камеры и особенности объектов.

4. Итак, как мы можем использовать его для обнаружения объекта? Ниже приведены процедуры, позволяющие выполнить базовое обнаружение с помощью этого инструмента:

Окно обнаружения Find-Object

5. Вы можете щелкнуть правой кнопкой мыши на левой боковой панели (Objects) этого окна, и вы получите возможность добавлять объекты из сцены. Если вы выберете эту опцию, вам будет предложено, пометить объект из текущей сцены, и после завершения маркировки отмеченный объект начнет отслеживаться со сцены. На предыдущем снимке экрана показан первый шаг, на котором происходит съемка сцены, имеющей объект.

6. После выравнивания объекта по направлению к камере нажмите кнопку “Take Picture”, чтобы сделать щелчок объекта:

Мастер добавления объектов для захвата объекта

7. Следующее окно предназначено для маркировки объекта из текущей привязки. На следующем рисунке показано это. Мы можем использовать указатель мыши для того чтобы отметить объект. Нажмите кнопку «Next», чтобы обрезать объект, и вы можете перейти к следующему шагу:

Следующее окно предназначено для маркировки объекта из текущей привязки. На следующем рисунке показано это. Мы можем использовать указатель мыши для того чтобы отметить объект. Нажмите кнопку «Next», чтобы обрезать объект, и вы можете перейти к следующему шагу:

Мастер добавления объектов для маркировки объекта

8. После обрезки объекта он покажет вам общее количество дескрипторов функций объекта, и вы можете нажать кнопку «End», чтобы добавить шаблон объекта для обнаружения. На следующем рисунке показан последний этап добавления шаблона объекта в это приложение-детектор:

Последний шаг мастера добавления объектов

9. Поздравляем! Вы добавили объект для обнаружения. Теперь вы сможете увидеть обнаружение, показанное в следующем снимке. Вы можете увидеть ограничивающий прямоугольник вокруг обнаруженного объекта:

Мастер Find-Object, запускающий обнаружение

10. Достаточно ли этого? Как насчет положения объекта? Мы можем получить

позиции объекта, используя следующую команду:

$ rosrun find_object_2d print_objects_detectedДетали объекта

11. Вы также можете получить полную информацию об обнаруженном объекте из

Вы также можете получить полную информацию об обнаруженном объекте из

/object темы. В этой теме публикуется многоадресный массив, состоящий из ширины и высоты объекта и матрицы гомографии для вычисления положения и ориентации объекта и его значений масштаба и сдвига. Вы можете echo the /objects topic получить так:

Значения темы /object

12. Мы можем вычислить новую позицию и ориентацию из следующих уравнений:

Уравнение для вычисления позиции объекта

Здесь H является гомографией 3 × 3 матрицы, (x1, y1) является позицией объекта в сохраненном изображении, а (x2, y2) является вычисленной позицией объекта в текущем кадре.

Вы можете проверить исходный код узла print_objected_src, чтобы получить onversion, используя матрицу гомографии.

Вот исходный код этого узла.

Видео тестирования пакета find_object_2d на примере алгоритмов ORB и SIFT

Резюме по алгоритмам: ORB быстрый, но не видит удаленные объекты и часто не правильно определяет геометрию. SIFT видит удаленные объекты, точно определяет геометрию, минусы требует больших вычислительных ресурсов и платный для коммерческого использования.

SIFT видит удаленные объекты, точно определяет геометрию, минусы требует больших вычислительных ресурсов и платный для коммерческого использования.

Вопросы которые предстоит решить по роботу EduMIP:

- Получать с камеры Logitech C920 на BeagleBone Blue уже аппаратно закодированное видео и передать его в таком виде на большой компьютер в ROS.

- Подключить датчики расстояния VL6180X, Vl53l0x и бампер, чтобы строить карту в ROS.(комплектующие уже заказаны)

- Написать алгоритм в ROS который будет обрабатывать данные карты и обнаруженных объектов с камеры и строить на основе них маршрут движения.

Если есть такие же энтузиасты робототехники как я, готовые включиться в проект, то пишите в личку, по вышеописанным вопросам нужна помощь.

Иммерсивное обнаружение / Immersive detection of NPC — Геймплей I Анимация — TES V: Skyrim LE — моды для Скайрим, Skyrim SE, Fallout 4, Fallout 76

Автор:kkil001

Версия:2. 5

5

Язык:русский

Описание:

Я люблю темные ночи в игре, но я ненавижу супер ночное видение которым обладают NPC! Это ведь получается смешно, когда я нахожусь в скрытном режиме и в тени, а в меня стреляет какой то NPC лучник, который в ста метрах от меня.

Обновление:2.5 («Иммерсивное освещение для NPC» 1.5b)

— NPC лучники человеческой расы не будут стрелять в вас в течение ночи, но они непременно выстрелят в вас в течение дня при обнаружении

— При обновлении данного модуля удалите скрипт lanternarmorscript.pex по адресу Data/Scripts в игре

Обновление:2.5 («Иммерсивное освещение для NPC» 1.4)

— Обновлен только опциональный модуль «Иммерсивное освещение для NPC» до версии 1.4, модуль «Иммерсивное обнаружение NPC» не обновлялся

— Все изменения для модуля «Иммерсивное освещение для NPC» 1.4 читайте в разделе Дополнительный аддон «Иммерсивное освещение для NPC» с пометкой «Новая возможность v1. 4″

4″

Обновление:2.5 («Иммерсивное освещение для NPC» 1.3)

— Обновлен только опциональный модуль «Иммерсивное освещение для NPC» до версии 1.3, модуль «Иммерсивное обнаружение NPC» не обновлялся

— Все изменения для модуля «Иммерсивное освещение для NPC» 1.3 читайте в разделе Дополнительный аддон «Иммерсивное освещение для NPC» с пометкой «Новая возможность v1.3»

Обновление:2.5

— Удалены все сообщения уведомления

— NPC в подземельях больше не имеют специальной способности обнаружения

— Добавлен автономный, новый вариант мода как дополнение (необязательное) «Иммерсивное освещение для NPC», подробности читайте ниже в разделе «Дополнительный аддон». Данный аддон можно использовать вместе с «Иммерсивным обнаружением» или по отдельности

Журнал изменений:

— Ничего в самом моде не изменилось, просто теперь использован очень чистый язык скриптов, чтобы реализовать все возможности которые были в предыдущей v2. 3, нет никакой привязки к заклинанию плаща, нет обновлений случайных событий, почти нулевое влияние на папирус (скрипты). Таким образом, на два файла скриптов стало меньше и они удалены, перед обновлением до версии 2.4 удалите некоторые скрипт файлы (читайте ниже что удалять перед обновлением)

3, нет никакой привязки к заклинанию плаща, нет обновлений случайных событий, почти нулевое влияние на папирус (скрипты). Таким образом, на два файла скриптов стало меньше и они удалены, перед обновлением до версии 2.4 удалите некоторые скрипт файлы (читайте ниже что удалять перед обновлением)

— Исправлен баг с «синим завихренем» у NPC, этот артефакт баг проявлялся при использовании заклинания невидимости

— Период различимых этапов обнаружения в зависимости от времени суток изменен, рассвет c 5 утра до 6 утра, закат с 6 часов вечера до 8 часов вечера, день с 6 утра до 6 вечера

— Плохая погода теперь будет иметь больше эффекта влияющего на обнаружение, чем в предыдущей версии 2.2

— Теперь внедрена система обнаружения по запаху, от исходящего от вас тепла и от ваших навыков (подробнее читайте ниже)

— Если вам не нравятся новые возможности и изменения в версии 2.3, то пользуйтесь версией 2.2

— У NPC добавлена система различимого зрения и слуха во время рассвета и заката

— Добавлены новые уведомления о смене времени суток (рассвет, день, закат, ночь)

— Добавлены новые уведомления предупреждения/советы

— Увеличена дальность зрения у NPC днем и ночью

— Интерьеры теперь полностью поддерживается

— Добавлена погодная система влияющая на обнаружение

— Фалмеры теперь на 100% слепы

— Все проблемы которые были в версии 1. 5 в категории «Известные проблемы» исправлены

5 в категории «Известные проблемы» исправлены

— Добавлены новые советы при загрузке игры

— При обновлении нужно удалить несколько скриптов, читайте ниже что делать

Подробнее:

— Этот мод содержит только два скрипта

— Этот мод улучшает поведение NPC в зависимости от дня и ночи

— Этот мод не будет ничего добавлять к вашему сохранению, так что вы можете удалить мод в любое время

— Этот мод не меняет никаких заклинаний NPC и AI интеллект, мод только изменяет значения обнаружения и все, так что настройка обнаружения возвратится к установкам из оригинальной игры, если вы удалите этот мод, поэтому мод должен быть совместим теоретически со всеми модами

— Этот мод обязательно требует установленный SKSE

Давайте посмотрим, что именно этот мод делает:

Зрение и слух у NPC будут отличаться в зависимости от времени суток:

— Рассвет (с 5 утра до 6 утра)

— День (с 6 утра до 6 вечера)

— Закат (с 6 утра до 8 вечера)

— Ночь (с 8 вечера до 5 утра)

Зрение NPC ночью и днем:

— В игре, в течении дня, NPC всегда будут видеть вас даже на очень дальней дистанции. Этот мод изменяет зрение у NPC и сделать зрение более реалистичным. В темное время суток и ночью, будет блокироваться зрение у NPC и их поле зрения. Все, что связано с их видением в темное время суток будет хуже, чем днем. Зрение у NPC не чувствительно к статическим вещам, это означает, что вы можете даже спокойно стоять в тени перед ними и они не заметят ваше присутствие, но они обнаружат вас независимо от того, двигаетесь вы или нет в светлое время суток.

Этот мод изменяет зрение у NPC и сделать зрение более реалистичным. В темное время суток и ночью, будет блокироваться зрение у NPC и их поле зрения. Все, что связано с их видением в темное время суток будет хуже, чем днем. Зрение у NPC не чувствительно к статическим вещам, это означает, что вы можете даже спокойно стоять в тени перед ними и они не заметят ваше присутствие, но они обнаружат вас независимо от того, двигаетесь вы или нет в светлое время суток.

Слух NPC ночью и днем:

— В дневное время суток, шаги игрока не будут слышать NPC, если вы держитесь на рсстоянии (но они будут слышать ваш шаг, если вы непосредственно позади них, конечно), NPC не будут слышать ваш шаг, если вы просто обойдете NPC или пройдете под ними, то есть если NPC сверху на какой нибудь высоте (только если вы не попадетесь им на глаза), это означает, что вам легче напасть на NPC сзади днем, чем ночью. Ночью как правило, все звуки усиливают свое звучание, нежели чем днем. NPC будут легко замечать ваше присутствие на слух, особенно если вы бежите. Бег будет почти всегда оповещать всех NPC о вашем присутствии ночью, так что лучше красться или носить легкие доспехи ночью (вы совершенно не будете слышими, если вы голый в дневное время суток, но будете услышаны, если вы пробежите слишком близко к NPC ночью, так что если вы хотите опробовать этот мод, вы можете попробовать полазать среди NPC голым)

Бег будет почти всегда оповещать всех NPC о вашем присутствии ночью, так что лучше красться или носить легкие доспехи ночью (вы совершенно не будете слышими, если вы голый в дневное время суток, но будете услышаны, если вы пробежите слишком близко к NPC ночью, так что если вы хотите опробовать этот мод, вы можете попробовать полазать среди NPC голым)

Зрение и слух NPC во время рассвета или заката:

— У NPC также слух и зрение будут меняться во время рассвета и заката. Во время заката, радиус обнаружения будет намного меньше, чем днем. Во время рассвета, обнаружение является самым слабым временным периодом у NPC, даже зрение у NPC становится немного больше, чем в ночное время суток, но их диапазон поиска и слух будет снижаться с наступлением ночи и до рассвета, поэтому это идеальное время, чтобы убивать во время рассвета.

В игре будут появляться сообщение о смене времени суток:

5 утра: время утренней зари

6 утра: вот и наступает день

6 вечера: солнце прячется за горизонтом

8 вечера: наступила ночь

Источник света:

— Этот мод также изменяет факторы, связанные с освещением, которое может повлиять на ваше обнаружение, вас легче будет обнаружить если вы находитесь рядом с источником света, так что, лучше просто придерживаться тени, неважно, днем или ночью!

Интерьеры:

— Все NPC в интерьерах больше не будут зависеть от дня и ночи, они теперь будут полагаться на слух, ваши шаги вызывают эхо, так что NPC могут услышать вас вдали, когда побежите. У всех NPC которые в подземельях(в интерьеарах) диапазон поиска будет больше, чем у NPC во внешней области. Их зрение будет слабее, чем у NPC во внешней области, однако, если вы находитесь рядом с источником света, они мгновенно вас обнаружат, потому что их глаза более чувствительны к свету. Люди NPC будут вас атаковать, как только увидят вас

У всех NPC которые в подземельях(в интерьеарах) диапазон поиска будет больше, чем у NPC во внешней области. Их зрение будет слабее, чем у NPC во внешней области, однако, если вы находитесь рядом с источником света, они мгновенно вас обнаружат, потому что их глаза более чувствительны к свету. Люди NPC будут вас атаковать, как только увидят вас

Система погоды:

— Во время дождя и снега, NPC будет труднее увидеть и услышать вас, особенно в ночное время, они почти слепы, если идет дождь или снег, но дождь и снег не помогут в дневное время, просто легкий эффект скрытности. Ваши шаги будет неслышимы в дождь или снег, так что это идеальное время, чтобы убить NPC в дождливую или снежную ночью. Снег создает больше эффекта к NPC, чем в дождь

Поиск и обнаружение:

— Диапазон зрения у NPC будет больше, чем в предыдущей v1.5 как днем, так и ночью. В дневное время, NPC лучник будет стрелять в вас мгновенно, если увидит вас и красться у вас больше не получится и скрытность не будет работать, если вы остаетесь на виду перед ними. (Советы: используйте препятствия, чтобы подойти к NPC и избежать обнаружение, препятствиями является все, при использовании этого мода). В ночное время, если вы стоите в диапазоне их зрения, они заметят, что что-то есть рядом и тогда пойдут и проверят то место, где вы нашумели, вы можете просто улизнуть во время их предстоящей проверки. NPC могут увидеть источник света, даже дальше, чем днем, так что, если вы активируете магический свет или любой другой источник освещения, который излучает свет, вы будете мгновенно обнаружены и расстреляны, как днем.

(Советы: используйте препятствия, чтобы подойти к NPC и избежать обнаружение, препятствиями является все, при использовании этого мода). В ночное время, если вы стоите в диапазоне их зрения, они заметят, что что-то есть рядом и тогда пойдут и проверят то место, где вы нашумели, вы можете просто улизнуть во время их предстоящей проверки. NPC могут увидеть источник света, даже дальше, чем днем, так что, если вы активируете магический свет или любой другой источник освещения, который излучает свет, вы будете мгновенно обнаружены и расстреляны, как днем.

Фалмеры:

— Фалмеры будут полностью слепы. Они будут полностью полагаться на свой слух, вы будете услышаны даже если находитесь далеко от них, но не будете обнаружены визуально, даже если вы будете просто стоять перед ними. Полезно будет присесть и оставаться на месте и смотреть, как Фалмеры будут просто ходить и пытаться найти вас, они прекратят свои поиски, даже если вы будете просто стоять перед ними при свете. Однако, у них есть супер слух … Вы будете найдены/обнаружены сразу же, если вы попытаетесь двигаться.

Однако, у них есть супер слух … Вы будете найдены/обнаружены сразу же, если вы попытаетесь двигаться.

Уведомления:

— Все уведомления удалены и не будут отображаться в левом верхнем углу экрана, но будут показываться новые небольшие советы, при загрузке игры

Запах, тепло, навыки:

— Ранее, вы могли использовать препятствия, чтобы избежать обнаружения, можно было прокрасться тихо, чтобы избежать слышимости, теперь это задача!

— Волк может учуять вас по запаху, вампир может обнаружить вас от исходящего от вас тепла

— Существует три типа обнаружения, по запаху, от тепла, от вашего мастерства. Вы будете атакованы NPC, в зависимости от конкретной ситуации

1.NPC которые обнаруживают вас по запаху: фалмеры, волки, белые медведи, оборотни

2.NPC которые обнаруживают вас от вашего тепла: вампиры, призраки, двемеры, нежить

3.NPC которые обнаруживают вас от вашей квалификации: каджиты, злокрысы, члены Темного братства

— У этих NPC система обнаружения будет затронута днем и ночь, во внутренних и внешних локациях

— В течение дня, только те NPC будут обнаруживать вас, которые имеют систему обнаружения по запаху, но не будут видеть и слышать вас

— NPC которые имеют систему обнаружения от исходящего тепла, не обнаружат вас, потому что от вас исходит тепло, в течение дня, также как и у всех живых существ и объектов, потому что все нагревается днем

— А вот ночью, все NPC которые упомянуты выше, будут обнаруживать вас, даже если они не видят и не слышат, так что помните, что кто-то смотрит на тебя сзади, пока ты убиваешь кого-то

— Если вы беспокоитесь о том, что мод будет затрагивать перки и навыки, то автор в моде ничего не изменял, и мод не влияет на перки, заклинания, способности

Итоги:

— Подводя итог, сделаем вывод. ..NPC будут больше полагаться на свое зрение в светлое время суток, но слух будет притуплен и будут больше полагаться на свой слух в ночное время, но зрение будет притуплено. Так что вы должны заботиться о том, чтобы не попадаться NPC на глаза в светлое время суток, но можете не беспокоиться о своем шаге и издаваемых звуках (конечно же, невозможно пройти мимо NPC, если вы носите тяжелую броню) и заботьтесь о своем шаге в ночное время суток, но можете не беспокоиться о том, что вас заметят NPC ночью (но все равно вас заметят, если вы только будете находиться прямо перед NPC). Если NPC услышит вас в ночи, то он будет ходить в определенной области и будет искать вас, а затем расширит область своего поиска, а в оригинале игры все бандиты в просто сразу начинают бежать к вам с оружием

..NPC будут больше полагаться на свое зрение в светлое время суток, но слух будет притуплен и будут больше полагаться на свой слух в ночное время, но зрение будет притуплено. Так что вы должны заботиться о том, чтобы не попадаться NPC на глаза в светлое время суток, но можете не беспокоиться о своем шаге и издаваемых звуках (конечно же, невозможно пройти мимо NPC, если вы носите тяжелую броню) и заботьтесь о своем шаге в ночное время суток, но можете не беспокоиться о том, что вас заметят NPC ночью (но все равно вас заметят, если вы только будете находиться прямо перед NPC). Если NPC услышит вас в ночи, то он будет ходить в определенной области и будет искать вас, а затем расширит область своего поиска, а в оригинале игры все бандиты в просто сразу начинают бежать к вам с оружием

— Если вы устроите бунт в форте в дневное время суток, то шум повлияет только на врага который рядом, враг который далеко не заметит шума, ведь днем всегда звуки и шум плохо различимы в конце концов

— Если активировать невидимость, NPC в игре все равно находят вас, стреляют в вас, ищут вас. ..из-за их супер слуха, но после использования этого мода, вражеские NPC будут знать, где вы находитесь только в течении 3 сек, после 3 сек, они потеряют свою цель и будут пытаться найти вас, вы можете просто бегать вокруг них, то есть перемещаться с места на место и вас они не найдут, но если вы подойдете к ним слишком близко, они заметят вас, где бы вы не находились и будут пытаться атаковать вас

..из-за их супер слуха, но после использования этого мода, вражеские NPC будут знать, где вы находитесь только в течении 3 сек, после 3 сек, они потеряют свою цель и будут пытаться найти вас, вы можете просто бегать вокруг них, то есть перемещаться с места на место и вас они не найдут, но если вы подойдете к ним слишком близко, они заметят вас, где бы вы не находились и будут пытаться атаковать вас

— Если у вас самый высокий ранг навыка скрытности (вас будет на 100% труднее обнаружить), если вы в стелс режиме, в скрытности и подойдете к NPC из-за спины, вы не будете обнаружены, но вы будете обнаружены, если вы в скрытном режиме подойдете к NPC с фронта, стелс мастерство только уменьшит расстояние слышимости, при котором NPC будет обнаруживать вас. NPC в дневное время суток будут обнаруживать вас, если вы примерно в 15 метрах в режиме скрытности находитесь фронтально по отношению к врагу и при 5 метрах в ночное время суток.

— И наконец, у NPC больше не будет того супер ночного видения! Вам никогда больше не придется беспокоиться о том, что на вас будут нападать и стрелять из ниоткуда!!!

Дополнительный аддон «Иммерсивное освещение для NPC»:

— Этот аддон необязательный файл, это для тех, кто любит иммерсивное поведение NPC в темноте. Все поведение NPC контролируется с помощью кода

Все поведение NPC контролируется с помощью кода

— Когда наступает ночь, все NPC находящиеся в «дикой природе», то есть за пределами городов, будут использовать источник света, только те, кто имеет навык изменения больше чем 20, могут использовать «Свет в ночи», другие NPC будут использовать факелы

— Если кто-то из NPC использует источник освещения находясь рядом с другим NPC, то этот NPC не будет использовать источник света

— NPC в городах или поселках или в любом доме, не будут использовать источник света, только NPC(люди) в дикой природе или в подземельях будут использовать источник света

— Каджиты, члены Темного братства, заключенные, вампиры не будут использовать источник света

— NPC, которые крадутся, сражаются, не будут использовать источник света

— Если NPC борется с вами с факелом, после нескольких секунд, он будет выбрасывать источник света на землю и будет бороться с вами дальше

— Только NPC имеющие навык «изменения» больше чем 20 и носящие робу мага, могут использовать освещение — Новая возможность v1. 3

3

— NPC имеющие навык «заклинания» больше чем 20 и носящие робу Некроманта, не будут использовать источник освещения — Новая возможность v1.3

— Иногда будет секундная задержка, чтобы NPC могли использовать источник освещения, задержку оснащения освещением можно заметить в течение ночи

— Мод не будет влиять на ваших компаньонов — Новая возможность v1.3

— NPC имеющие магический эффект невидимсоти, не будут использовать источник освещения — Новая возможность v1.3

— У NPC будут переносные фонари, NPC с двуручным оружием (включая лук и щит), будут использовать переносной фонарь вместо факела — Новая возможность v1.4

— NPC лучники человеческой расы не будут стрелять в вас в течение ночи, но они непременно выстрелят в вас в течение дня при обнаружении — Новая возможность v1.5b

Совместимость:

— Совместим с Skyre

— Совместим с Perma

— Совместим с Realistic Night

— Совместим со всеми модами на заклинания

— Совместим со всеми боевыми модами

— Совместим со всеми модами на изменение перков

— Совместим со всеми модами на изменение АI интеллекта у NPC

— Совместим со всеми модами на компаньонов

— Совместим со всеми модами изменяющими освещение, такие как RLO, ELFX, COT

— Не совместим с Requiem? (мнение спорное, 50х50, можете использовать совместно, все равно на сохранение не повлияет)

— Не совместим с Immersive NPC in the dark

— Не совместим с Improved sneak detection

— Если вы беспокоитесь о том, что мод будет затрагивать перки и навыки, то автор в моде ничего не изменял, и мод не влияет на перки, заклинания, способности

— В моде использован простой код и скрипты не изменяют какие-либо данные у NPC перков, заклинаний, способностей. В моде изменены только значения обнаружения

В моде изменены только значения обнаружения

— В целом, этот мод не изменяет ничего что связано с заклинаниями, способностями, навыками, но мод не совместим с модами, которые изменяют значения обнаружения

Требования:

— Версия игры 1.9.32.0.8

— SKSE 1.06.16 или 1.07.01 и выше

При обновлении с версии 2.х до версии 2.5:

— Обязательно удалите файлы specialdetector.pex и ApplyingScript.pex по адресу Data/Scripts (если таковые имеются)

— Обязательно удалите файлы specialdetector.psc и ApplyingScript.psc по адресу Data/Scripts/Source (если таковые имеются)

— Установите новую версию поверх с заменой файлов

При обновлении с версии 1.5 до версии 2.5:

— Обязательно удалите скрипты LoadGame.pex, RNS.pex, specialdetector.pex и ApplyingScript.pex по адресу Data/Scripts (если таковые имеются)

— Обязательно удалите скрипты LoadGame.psc, RNS.psc, specialdetector.pex и ApplyingScript.pex по адресу Data/Scripts/Source (если таковые имеются)

— Установите новую версию поверх с заменой файлов

Установка:(можно вручную или через NMM менеджер)

Поместите папку Data из архива в папку с игрой (не Data внутрь Data, а поверх), подтвердите слияние папок и активируйте в лаунчере

Удаление:

Просто удалите все файлы и скрипты мода

Порядок загрузки:

В самый низ в лаунчере

youtube.com/embed/qbGs-NIBuls»/>

«Иммерсивное обнаружение NPC» и аддон «Иммерсивное освещение для NPC» можно использовать вместе или по отдельности

По осн.ссылке «Иммерсивное обнаружение NPC» v2.5 — Не обновлялся

По доп.ссылке аддон «Иммерсивное освещение для NPC» v1.5b — Обновлено

Функция обнаружения движущихся объектов (MOD) :: Монитор заднего и широкого обзора с обнаружением движущихся объектов (MOD) (если таковой имеется) :: Монитор, обогреватель, кондиционер, аудио, телефон и системы распознавания голоса :: Nissan Murano 2009 -2021 Руководство по эксплуатации :: Nissan Murano

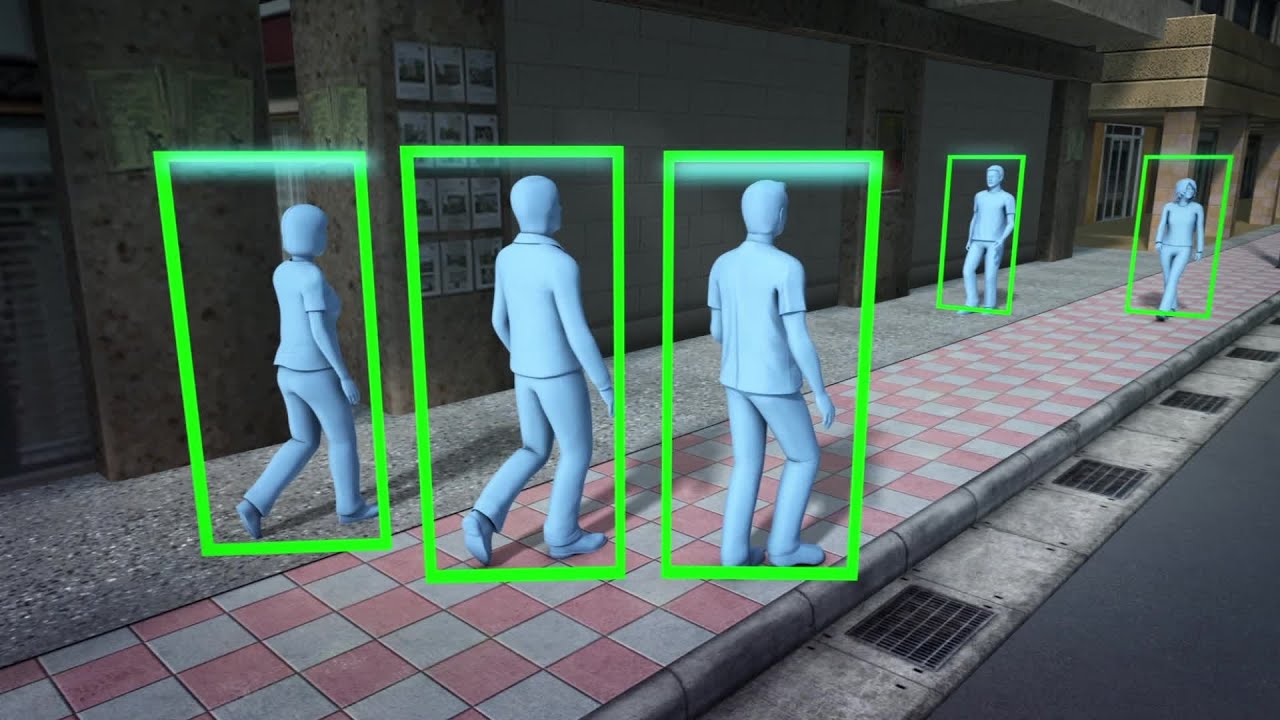

Система обнаружения движущихся объектов (MOD) может сообщить водителю о движущихся объектах, когда выезд из гаража, заезд на стоянку лоты и в других подобных случаях.

Система MOD обнаруживает движущиеся объекты по

используя технологию обработки изображений на

изображение, отображаемое на дисплее. Вид сзади

камера оборудована автоматической мойкой

работать с жидкостью для стеклоомывателя.

Вид сзади

камера оборудована автоматической мойкой

работать с жидкостью для стеклоомывателя.

Когда рычаг переключения передач находится в положении R (задний ход) положение и скорость автомобиля приблизительно 5 миль в час (8 км / ч) или меньше, система MOD обнаруживает движущиеся объекты в мониторе заднего вида.

Система MOD не будет работать, если подъемные ворота / Открыт багажник или низкий уровень омывающей жидкости.

ПРЕДУПРЕЖДЕНИЕ

• Система MOD не заменяет для правильной эксплуатации автомобиля и не препятствует контакту с предметы, окружающие автомобиль.

При маневрировании всегда используйте

наружное зеркало и зеркало заднего вида

и повернуться и посмотреть, чтобы проверить

окружение, чтобы убедиться, что это безопасно

маневрировать.

• Система MOD не предназначена для

обнаруживать окружающие неподвижные объекты.

Если система MOD обнаруживает движущиеся объекты

позади автомобиля будет желтая рамка. отображается на камере изображение и звуковой сигнал

звуки.

отображается на камере изображение и звуковой сигнал

звуки.

Когда система MOD обнаруживает движущийся объект позади автомобиля желтая рамка будет отображается на виде, где находятся объекты обнаружен, и раздастся звуковой сигнал.В то время как Система MOD продолжает обнаруживать движение объекты, желтая рамка продолжает оставаться отображается.

При обнаружении грязи на камере во время во время движения омыватель камеры работает автоматически.

Стиральная машина прекратит работу через некоторое время. время.

ПРЕДУПРЕЖДЕНИЕ

• Не используйте систему MOD, когда

буксировка прицепа. Система не может

работает должным образом.

• Чрезмерный шум (например, звук

объем системы или открытый автомобиль

окно) будет мешать

Звук звонка, а может и не быть

слышал.

• Производительность системы MOD будет

быть ограниченным в зависимости от окружающей среды

условия и окружающие предметы

например:

— При низком контрасте между

фон и движущиеся

объекты

— Когда мигает источник

свет.

— При ярком свете типа другого

фара автомобиля или солнечный свет

настоящее.

— Когда есть грязь, капли воды

или снег на объективе камеры.

— Когда положение движется

объектов на дисплее нет

измененный.

• Система MOD может обнаруживать

что-то вроде текущих капель воды

на объектив фотоаппарата, белый

дым из глушителя, движущийся

тени и т. д.

• Система MOD может не работать

правильно в зависимости от скорости,

направление, расстояние или форма

движущиеся объекты.

• Если ваш автомобиль поврежден

части, где камера

установлен, оставив его смещенным или

изогнутый, зона чувствительности может быть

изменены, и система MOD может

не обнаруживают объекты должным образом.

Включение и выключение системы MOD

1. Нажмите кнопку НАСТРОЙКА, выберите «Драйвер Помощь »и нажмите ENTER. кнопка.

2. Затем выберите «Обнаружение движущихся объектов». (MOD) ”и нажмите кнопку ENTER.

Когда система MOD включена, MOD

Значок1 отображается.

MOD неисправность

Когда желтый значок MOD отображается в вид, система не работает должным образом.Этот не будет препятствовать нормальному движению, но система должна быть проверена NISSAN дилер.

Обслуживание камеры

Если на камере скапливается грязь, дождь или снег, система MOD может работать некорректно.

Очистите камеру.

Омыватель камеры работает автоматически при обнаружении грязи на камере во время вождение. Стиральная машина прекращает работу после промежуток времени.

См. Также:

Антенна

Антенну нельзя укорачивать, но можно

удаленный.Когда вам нужно снять антенну,

поверните стержень антенны против часовой стрелки B. Чтобы установить стержень антенны, поверните стержень антенны

по часовой стрелке A …

Указатель уровня топлива

Манометр показывает приблизительный уровень топлива.

в баке. Датчик может немного двигаться во время торможения,

повороты, ускорение, подъем или спуск с холма. Стрелка манометра вернется к E (Пусто …

Стрелка манометра вернется к E (Пусто …

Запирание ключом

Сторона водителя

Система дверного замка с электроприводом позволяет запирать или

открыть все двери одновременно.Поворот ключа к передней части 1 автомобиля

запирает все двери. Поворачивая ключ один раз …

Обнаружение движущихся объектов (MOD) — Монитор кругового обзора (если он есть) — Монитор, климат, аудио, телефон и системы распознавания голоса — Руководство пользователя Infiniti JX — Infiniti JX

Система обнаружения движущихся объектов (MOD) может информировать водителя о движущихся объектах, окружающих автомобиль, при выезде из гаража, маневрировании на стоянке и в других подобных случаях.

Система MOD обнаруживает движущиеся объекты, используя технологию обработки изображения на изображении, отображаемом на дисплее.

Система MOD работает в следующих условиях, когда отображается изображение камеры:

● Когда селектор переключения передач находится в положении P или N и автомобиль остановлен, система MOD обнаруживает движущиеся объекты с высоты птичьего полета. Система MOD не будет работать, если наружное зеркало выдвигается или выдвигается, или если одна из дверей открыта.

Система MOD не будет работать, если наружное зеркало выдвигается или выдвигается, или если одна из дверей открыта.

● Когда селектор переключения передач находится в положении D и скорость автомобиля ниже примерно 5 миль в час (8 км / ч), система MOD обнаруживает движущиеся объекты в виде спереди или в поле зрения спереди.

● Когда селектор переключения передач находится в положении R и скорость автомобиля ниже примерно 5 миль в час (8 км / ч), система MOD обнаруживает движущиеся объекты в поле зрения или в целом сзади. Система MOD не будет работать, если задняя дверь открыта.

Система MOD не обнаруживает движущиеся объекты при виде спереди. В этом режиме значок MOD не отображается на экране.

ПРЕДУПРЕЖДЕНИЕ

● Система MOD не заменяет надлежащую работу автомобиля и не предназначена для предотвращения контакта с объектами, окружающими автомобиль.При маневрировании всегда пользуйтесь наружным зеркалом и зеркалом заднего вида, поворачивайте и проверяйте окружающее, чтобы убедиться, что маневрировать безопасно.

● Система MOD не имеет функции обнаружения окружающих неподвижных объектов.

Если система MOD обнаруживает движущиеся объекты, окружающие автомобиль, на изображении камеры отображается желтая рамка и раздается звуковой сигнал.

Когда система MOD обнаруживает движущийся объект, окружающий автомобиль, желтая рамка будет отображаться в области обзора, где обнаружены объекты, и прозвучит один раз звуковой сигнал.Пока система MOD продолжает обнаруживать движущиеся объекты, желтая рамка продолжает отображаться.

При виде с высоты птичьего полета желтая рамка 1 отображается на каждом изображении камеры (спереди, сзади, справа, слева) в зависимости от того, где обнаружены движущиеся объекты.

Желтая рамка 2 отображается на каждом виде в режимах вида спереди, вида спереди, вида сзади и вида сзади.

Пока гидролокатор или звуковой сигнал BCI (если таковой имеется) подает звуковой сигнал, система MOD не подает звуковой сигнал.

Синий значок MOD отображается в окне, в котором работает система MOD. Серый значок MOD отображается в том виде, в котором система MOD не работает.

Когда нажата клавиша MOD 4, система MOD временно отключится, а индикатор 5 погаснет. В то же время гидролокатор камеры также будет выключен. При повторном нажатии кнопки загорится индикатор и снова включится система MOD.

Если система MOD отключена, значок MOD 3 не отображается.

Система MOD включается автоматически при следующих условиях:

● Когда селектор переключения передач находится в положении R.

● При нажатии кнопки КАМЕРА для переключения с другого экрана на изображение камеры на дисплее

● Когда скорость автомобиля снижается ниже примерно 5 миль / ч (8 км / ч).

● Когда ключ зажигания переводится в положение ВЫКЛ, а затем обратно в положение ВКЛ.

Чтобы настроить систему MOD так, чтобы она всегда оставалась выключенной, используйте меню настроек камеры. Дополнительные сведения см. В разделе «Параметры монитора кругового обзора» в этом разделе.

Дополнительные сведения см. В разделе «Параметры монитора кругового обзора» в этом разделе.

ПРЕДУПРЕЖДЕНИЕ

● Не используйте систему MOD при буксировке прицепа. Система может работать некорректно.

● Чрезмерный шум (например, громкость аудиосистемы или открытое окно автомобиля) будет мешать звуку перезвона, и он может быть не слышен.

● Производительность системы MOD будет ограничена в зависимости от условий окружающей среды и окружающих объектов, таких как:

Когда низкий контраст между фоном и движущимися объектами.

Когда есть мигающий источник света.

Когда присутствует сильный свет, например фара другого автомобиля или солнечный свет.

Когда камера ориентирована не в обычном положении, например, когда зеркало сложено.

Если на объективе камеры есть грязь, капли воды или снег.

Когда положение движущихся объектов на дисплее не меняется.

● Система MOD может обнаруживать что-то вроде текущих капель воды на объективе камеры, белого дыма из глушителя, движущихся теней и т. Д.

Д.

● Система MOD может работать неправильно в зависимости от скорости, направления, расстояния или формы движущихся объектов.

● Если в вашем автомобиле повреждаются детали, на которых установлена камера, в результате чего он остается смещенным или изогнутым, зона обнаружения может измениться, и система MOD может не обнаруживать объекты должным образом.

Обслуживание камеры

Если на камере скапливается грязь, дождь или снег, система MOD может работать неправильно. Очистите камеру.

См. Также:

Передача камердинером

Если вам нужно оставить ключ у камердинера, отдайте им сам интеллектуальный ключ и держите механический ключ при себе, чтобы защитить свои вещи.

Чтобы бардачок и багажник не открывались …

Система помощи при трогании с места

ПРЕДУПРЕЖДЕНИЕ

► Никогда не полагайтесь только на систему помощи при трогании с холма.

система предотвращения движения автомобиля

движение назад по холму. Всегда води

внимательно и внимательно. Подавить

педаль тормоза когда…

Всегда води

внимательно и внимательно. Подавить

педаль тормоза когда…

Меры предосторожности при трогании с места и вождении

ПРЕДУПРЕЖДЕНИЕ

► Не оставляйте детей или взрослых, которые

обычно требует поддержки

другие одни в вашем автомобиле. Домашние животные должны

тоже не оставайся в покое. Они могли

случайно травмировать …

Системы кругового обзора и обнаружения движущихся объектов от Nissan и Clarion по лицензии Hitachi

Размещено компанией Matrix 22 декабря 2014 г.

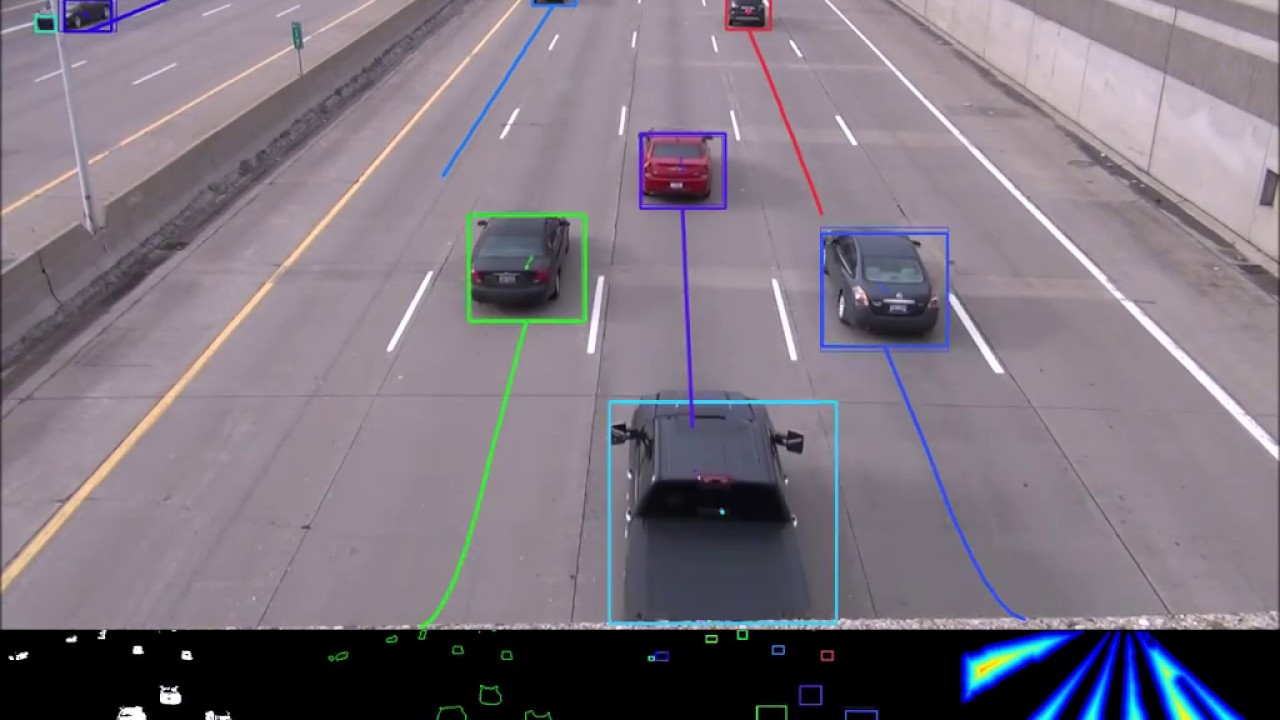

Nissan Motor Co Ltd объявила о лицензировании технологии Around View Monitor и обнаружения движущихся объектов (MOD), разработанной совместно с Clarion Co Ltd, для использования Hitachi Construction Machinery.Эти две инновационные системы являются строительными блоками технологии автономного вождения, которая будет использоваться в коммерческих автомобилях Nissan Autonomous Drive к 2020 году.

Around View Monitor (AVM) — это система поддержки парковки, которая предлагает водителю обзор окружающей среды с высоты птичьего полета в реальном времени с помощью четырех внешних камер. MOD — это технология помощи при вождении, которая анализирует изображения с камер AVM, чтобы обнаруживать движущиеся объекты вокруг автомобиля и предупреждать водителя визуальными и звуковыми сигналами.С момента выхода на рынок AVM в 2007 году и MOD в 2010 году, впервые для любого автопроизводителя, Nissan неуклонно расширял свои предложения технологий безопасности, которые, по его словам, «стали краеугольным камнем развития технологий автономного привода».

MOD — это технология помощи при вождении, которая анализирует изображения с камер AVM, чтобы обнаруживать движущиеся объекты вокруг автомобиля и предупреждать водителя визуальными и звуковыми сигналами.С момента выхода на рынок AVM в 2007 году и MOD в 2010 году, впервые для любого автопроизводителя, Nissan неуклонно расширял свои предложения технологий безопасности, которые, по его словам, «стали краеугольным камнем развития технологий автономного привода».

Лицензионное соглашение позволяет Hitachi Construction Machinery предоставлять технологии AVM и MOD для своих карьерных самосвалов и гидравлических экскаваторов, работающих в крупных карьерах. Когда водители начинают управлять транспортным средством, сбрасывают груз, возвращаются назад для загрузки груза или когда гидравлический экскаватор используется в непосредственной близости от транспортного средства, технология AVM-MOD обнаруживает любое движение или рабочих в районе вокруг него в режиме реального времени, что позволяет водитель должен работать с большей ситуационной осведомленностью, что повышает безопасность.

Nissan «будет способствовать развитию технологий за счет применения своих уникальных технологий и ноу-хау для собственного использования, а также в различных областях. Прибыль, полученная за счет эффективного использования этих нематериальных активов, будет инвестирована в развитие новых технологий, что в дальнейшем будет способствовать повышению технологической компетенции Nissan ». Автономный привод разрабатывается, чтобы помочь снизить элемент человеческой ошибки во время вождения и внести свой вклад в сокращение количества аварий и травм, связанных с автомобилями.«Лицензирование этой технологии является примером намерения Nissan предложить технологии AVM и MOD другим отраслям, помимо автомобильного. Благодаря более широкому применению своих технологий безопасности Nissan стремится внести свой вклад в развитие общества ».

Сеть обнаружения движущихся объектов на основе движения и внешнего вида для автономного вождения

сигналов движения и внешнего вида для обнаружения движущихся объектов.

Это обеспечивает гибкость для обнаружения необученных объектов чисто

на основе сигналов движения для редких транспортных средств, таких как строительные

грузовики.Наш подход превосходит современную однопотоковую сеть MPnet

на 21,5% в mAP на расширенном наборе данных KITTI

(KITTI MOD). В заключение, эта проблема

еще далека от решения и развертывания в реальной системе, а

главным узким местом является отсутствие больших разнообразных наборов данных для сегментации движения

.

СПИСОК ЛИТЕРАТУРЫ

[1] С. Бейкер, Д. Шарстейн, Дж. Льюис, С. Рот, М. Дж. Блэк и Р. Шелиски,

«База данных и методология оценки оптических потоков», Междунар. Журнал компьютерного зрения, т.92, нет. 1, pp. 1–31, 2011.

[2] M. Bojarski, D. Del Testa, D. Dworakowski, B. Firner, B. Flepp,

P. Goyal, LD Jackel, M. Monfort, U Мюллер, Дж. Чжан и др., «End to

end learning for беспилотные автомобили», препринт arXiv arXiv: 1604. 07316,

07316,

2016.

[3] Т. Брокс и Дж. Малик, «Объект. сегментация путем долгосрочного анализа

точечных траекторий », Computer Vision – ECCV 2010, стр. 282–295, 2010.

[4] Б. Драйер и Т. Брокс,« Обнаружение, отслеживание и движение объектов.

сегментация. для сегментации видео на уровне объектов », препринт arXiv

arXiv: 1608.03066, 2016.

[5] А. Фактор и М. Ирани, «Сегментация видео на основе нелокального консенсуса

голосования». в BMVC, т. 2, вып. 7, 2014, с. 8.

[6] К. Фрагкиадаки, П. Арбелаез, П. Фелсен и Дж. Малик, «Обучение

сегментовдвижущихся объектов в видео», в материалах конференции IEEE

по компьютерному зрению и распознаванию образов. , 2015, стр.

4083–4090.

[7] А. Гейгер, М. Лауэр, К. Войек, К. Стиллер и Р. Уртасун, «3D-трафик

понимание сцены с подвижных платформ», транзакции IEEE по анализу паттернов

и машинному интеллекту, том .36, нет. 5, pp. 1012–

1025, 2014.

[8] А. Гейгер, П. Ленц, К. Стиллер и Р. Уртасун, «Зрение встречает робототехнику:

Набор данных kitti», Международный журнал робототехники Research (IJRR),

2013.

[9] А. Гейгер, П. Ленц и Р. Уртасун, «Готовы ли мы к автономному вождению

? набор тестов kitti vision », в Conference on Computer

Vision and Pattern Recognition (CVPR), 2012.

[10] R. Girshick,« Fast r-cnn », в Proceedings of the IEEE International

Conference on Computer Видение, 2015, стр.1440–1448.

[11] Р. Гиршик, Дж. Донахью, Т. Даррелл и Дж. Малик, «Региональные сверточные сети

для точного обнаружения и сегментации объектов», транзакции IEEE по анализу образов и машинному интеллекту. ,

т. 38, нет. 1, pp. 142–158, 2016.

[12] С.Д. Джайн, Б. Сюн и К. Грауман, «Fusionseg: обучение

объединить движение и внешний вид для полностью автоматического разделения

общих объектов в видео. Препринт arXiv arXiv: 1701.05384, 2017.

[13] И. Коккинос, «Ubernet: обучение универсальной сверточной нейронной сети —

, работа для низкого, среднего и высокого уровня зрения с использованием различных наборов данных и

ограниченной памяти», препринт arXiv arXiv: 1609.02132, 2016.

[14] Й. Дж. Ли, Дж. Ким и К. Грауман, «Ключевые сегменты для сегментации видеообъекта

», в Computer Vision (ICCV), 2011 IEEE International

Conference on. IEEE, 2011, стр. 1995–2002.

[15] В. Лю, Д. Ангелов, Д.Erhan, C. Szegedy, S. Reed, C.-Y. Fu,

и А. К. Берг, «Ssd: однократный детектор с несколькими ящиками», на Европейской конференции по компьютерному зрению

. Springer, 2016, стр. 21–37.

[16] Дж. Лонг, Э. Шелхамер и Т. Даррелл, «Полностью сверточные сети

для семантической сегментации», в Трудах конференции IEEE

по компьютерному зрению и распознаванию образов, 2015, стр. 3431– 3440.

[17] Н. Майер, Э. Ильг, П. Хауссер, П. Фишер, Д. Кремерс, А.Досовицкий,

и Т. Брокс, «Большой набор данных для обучения сверточных сетей для оценки диспаратности

, оптического потока и потока сцены», в Proceedings of

the IEEE Conference on Computer Vision and Pattern Recognition,

2016, С. 4040–4048.

[18] М. Мензе и А. Гейгер, «Поток объектов сцены для автономных транспортных средств», в материалах конференции IEEE по компьютерному зрению и

распознаванию образов, 2015, стр. 3061–3070.

[19] П. Охс, Дж. Малик и Т. Брокс, «Сегментация движущихся объектов с помощью долгосрочного видеоанализа

», транзакции IEEE по анализу паттернов и

машинного интеллекта, т. 36, нет. 6, pp. 1187–1200, 2014.

[20] А. Папазоглу и В. Феррари, «Быстрая сегментация объектов в видео без напряжения

», Материалы Международной конференции IEEE

по компьютерному зрению, 2013 г. С. 1777–1784.

[21] Ф. Перацци, Дж. Понт-Тусет, Б.McWilliams, L. Van Gool, M. Gross и

A. Sorkine-Hornung, «Тестовый набор данных и метод оценки для сегментации видеообъектов», в Computer Vision and Pattern

Recognition, 2016.

[22] Дж. Редмон, С. Диввала, Р. Гиршик и А. Фархади, «Вы посмотрите

только один раз: унифицированное обнаружение объектов в реальном времени», в материалах конференции IEEE

по компьютерному зрению и шаблонам. Признание, 2016, с.

779–788.

[23] Дж.Редмон и А. Фархади, «Yolo9000: лучше, быстрее, сильнее», arXiv

препринт arXiv: 1612.08242, 2016.

[24] С. Рен, К. Хе, Р. Гиршик и Дж. Сан, «Быстрее r-cnn: На пути к обнаружению объектов в реальном времени

с помощью сетей предложения регионов », в Advances in

neural processing systems, 2015, pp. 91–99.

[25] М. Сиам, «Многозадачное обучение с помощью движения и внешнего вида», http:

//webdocs.cs.ualberta.ca/∼mennatul/?p=99, 2017.

[26] K .Симонян, А. Зиссерман, «Двухпотоковые сверточные сети

для распознавания действий в видео», Успехи в системах обработки нейронной информации

, 2014, стр. 568–576.

[27] Б. Тейлор, В. Карасев и С. Соатто, «Причинная сегментирование видеообъектов —

в результате сохранения окклюзий», Материалы конференции IEEE

по компьютерному зрению и распознаванию образов, 2015 г., С.

4268–4276.

[28] М. Тайхманн, М. Вебер, М.Зёлльнер, Р. Чиполла и Р. Уртасун,

«Multinet: совместное семантическое обоснование в реальном времени для автономного вождения», препринт arXiv arXiv: 1612.07695, 2016.

[29] П. Токмаков, К. Алахари и К. Шмид, «Изучение моделей движения

в видео», препринт arXiv arXiv: 1612.07217, 2016.

[30] PH Торр, «Сегментация геометрического движения и выбор модели»,

Philosophical Transactions of the Royal Society of London A: Math-

ematical, Physical and Engineering Sciences, vol.356, нет. 1740, pp.

1321–1340, 1998.

[31] С. Виджаянарасимхан, С. Рикко, К. Шмид, Р. Суктанкар и

К. Фрагкиадаки, «Sfm-net: изучение структуры и движения. из

видео », препринт arXiv arXiv: 1704.07804, 2017.

[32] С. Вервайн и Р. Шелиски,« Сегментация видео с фоном

моделей движения ». в BMVC, 2017.

[33] Х. Сюй, Й. Гао, Ф. Ю и Т. Даррелл, «Сквозное обучение

моделей вождения на основе крупномасштабных наборов видеоданных», препринт arXiv

arXiv: 1612.01079, 2016.

Обнаружение движущихся объектов на основе оценки оптического потока и модели гауссовской смеси для усовершенствованных систем помощи водителю

Аннотация

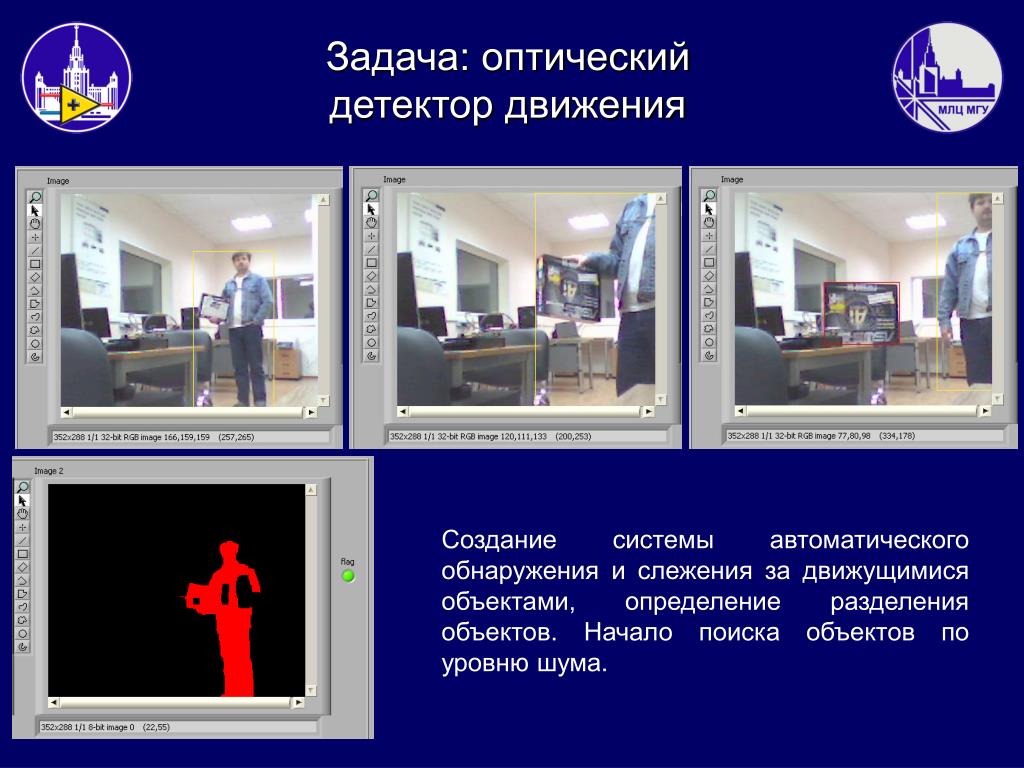

Большинство подходов к обнаружению движущихся объектов (MOD) на основе компьютерного зрения ограничены средами со стационарными камерами. Однако в усовершенствованных системах помощи водителю (ADAS) эго-движение добавляется к кадрам изображения из-за использования движущейся камеры. Это приводит к смешанному движению в кадрах изображения и затрудняет классификацию целевых объектов и фона.В этой статье мы предлагаем эффективный алгоритм MOD, который может справиться с движущейся камерой. Кроме того, мы представляем дизайн оборудования и результаты реализации для обработки предложенного алгоритма в реальном времени. Предлагаемый детектор движущихся объектов был разработан с использованием языка описания оборудования (HDL), а его производительность в реальном времени была оценена с помощью тестовой системы на основе FPGA. Экспериментальные результаты показывают, что наша конструкция обеспечивает лучшую производительность обнаружения, чем существующие системы MOD.Предлагаемый детектор движущихся объектов был реализован с помощью логических срезов 13,2 тыс., 104 DSP48 и 163 BRAM и может поддерживать обработку в реальном времени со скоростью 30 кадров в секунду на рабочей частоте 200 МГц.

Ключевые слова: ADAS, вычитание фона, FPGA, обнаружение движущихся объектов, оценка оптического потока

1. Введение

Усовершенствованные системы помощи водителю (ADAS) представляют собой наиболее популярную область в автомобильной промышленности и стали ключевой технологией для безопасность современного автомобиля и комфорт вождения [1,2].Наиболее часто используемые методы ADAS включают адаптивный круиз-контроль, предупреждение о столкновении и помощь при смене полосы движения. Системы предупреждения о столкновении являются одним из основных приложений ADAS, и их задача состоит в том, чтобы информировать водителей о препятствиях вокруг транспортного средства посредством визуальной, звуковой или тактильной обратной связи [3,4]. Технология надежного обнаружения движущихся объектов (MOD) является неотъемлемой частью систем предупреждения о столкновениях, и были предложены различные методы на основе датчиков, такие как методы на основе видения, лидаров и радаров [5,6].Поскольку технология MOD на основе зрения относительно более интуитивна и дешевле, чем методы активных датчиков, такие как радар и лидар, было предложено множество алгоритмов на основе зрения [7,8,9,10,11,12,13,14,15, 16,17,18,19,20,21,22,23,24,25,26,27,28,29].

Однако несколько алгоритмов MOD на основе машинного зрения предполагают, что кадры входного изображения будут захвачены стационарной камерой, поскольку точность обнаружения ухудшается для движущихся камер [8,9,10,11,12,13,14]. Хотя методы создания фоновых моделей с использованием интеллектуальных камер также были предложены, они страдают ограничением в том, что их можно использовать только в среде со стационарными камерами [15,16,17].Без должного различия трудно различить смешанное движение между объектами заднего и переднего плана, вызванное движущимися камерами. Использование движущейся камеры в транспортных средствах неизбежно, и поэтому необходим эффективный алгоритм, который может справиться с этим фактом.

По этой причине недавно были предложены несколько алгоритмов, которые позволяют использовать MOD в кадрах изображения, полученных с помощью движущихся камер [18,19,20,21,22,23,24,25,26,27,28,29]. Некоторые из этих методов используют передовые статистические модели или методы обнаружения выбросов для оценки фона [18,19,20,21,22,23,24].В ссылке [22] было предложено вычитание фона на основе модели фона 2.5D, которую можно использовать для успешного обнаружения движущихся объектов в сложных сценах. В ссылке [23] был представлен быстрый и эффективный алгоритм MOD, основанный на глобальной компенсации движения и адаптивном моделировании фона, который поддерживает обнаружение объектов в реальном времени на движущейся камере. Метод, предложенный в ссылке [24], представляет новый подход к фоновому моделированию, основанный на динамическом обратном анализе (DRA). Этот подход позволяет справиться с вариациями освещения, окклюзиями и нестабильностью камеры.Исчерпывающий обзор недавних попыток работы с вариациями освещения и окклюзиями можно найти в ссылке [25]. Недавно были также предложены алгоритмы, основанные на глубоких нейронных сетях (DNN) [26,27,28]. В методе, предложенном в ссылке [28], одиночная CNN обучается с использованием сложенных по глубине пар изображение-фон, а ее выходные данные улучшаются с помощью постобработки. Однако эти алгоритмы могут не подходить для приложений ADAS с ограниченным энергопотреблением и доступной площадью из-за связанной с ними высокой вычислительной сложности и огромных требований к памяти.Кроме того, алгоритмы, основанные на методах обучения, не могут справиться с неожиданными ситуациями, потому что кадры изображений, используемые для обучения, ограничены конкретными случаями [29]. В частности, использование движущихся камер приводит к большому количеству возможных ситуаций, что серьезно ухудшает производительность MOD.

С другой стороны, был предложен метод компенсации движения камеры, называемый движением эго, без использования методов обучения [29]. Алгоритм MOD, предложенный в ссылке [29], оценивает вектор потока каждого пикселя с помощью алгоритма оценки оптического потока (OFE) на основе Лукаса Канаде (LK) и анализирует гистограмму векторов потока для оценки движения эго.Затем фоновая модель компенсируется с использованием оцененного движения эго. Модель скомпенсированного фона используется в процессе MOD для разделения смешанного движения между объектами фона и переднего плана. Этот алгоритм может предотвратить множество ложных срабатываний и показывает хорошую точность в условиях движущейся камеры. Однако есть проблема в том, что его характеристики с точки зрения отзыва ухудшаются. Следовательно, его приложения ограничены резервным вмешательством при столкновении (BCI), которое заключается в обнаружении препятствий позади транспортного средства, поскольку такие задачи требуют относительно медленного движения камеры, как описано в ссылке [29].Этот недостаток возникает из-за использования OFE на основе LK для оценки движения эго. OFE на основе LK — это локальный метод оценки векторов потока, основанный на предположении, что движение локальной области одинаково внутри нее самой. Ограничением этого метода является то, что он не может найти правильные векторы потока в областях, где картина яркости однородна. Следовательно, неточные векторы потока, оцененные в фоновых областях с однородными структурами яркости, оказывают неблагоприятное влияние на оценку движения эго.

Чтобы преодолеть проблемы, связанные с использованием локальных методов, таких как OFE на основе LK, Хорн и Шунк (HS) предложили глобальный метод для определения функции энергии всего кадра изображения и для оценки векторов потока, пока минимизация этой энергетической функции [30]. Однако этот метод не справляется с внезапными изменениями яркости, и для решения этой проблемы были предложены различные алгоритмы [31,32,33]. Среди них алгоритм Брокса показывает устойчивость к изменениям яркости, расширяя обычное предположение постоянства яркости OFE до предположения постоянства градиента.Он также показывает более высокую точность, чем другие алгоритмы в условиях автомобиля.

В этой статье мы предлагаем эффективный алгоритм поиска движущихся объектов после более точной оценки и компенсации эго-движения с помощью алгоритма Brox OFE. Кроме того, мы представляем проект структуры оборудования и его результаты для задач обработки в реальном времени. Остальная часть этой статьи организована следующим образом: Раздел 2 объясняет алгоритм Brox OFE и модель смеси Гаусса (GMM). В разделе 3 представлен предлагаемый алгоритм MOD, а в разделе 4 описана аппаратная архитектура предлагаемого детектора движущихся объектов.В разделе 5 представлены результаты реализации предлагаемого детектора движущихся объектов на ПЛИС и результаты оценки производительности. Наконец, раздел 6 завершает статью.

2. Сопутствующие работы

2.1. Оценка оптического потока Brox

Пусть x = (x, y, t) T и w = (u, v, 1) T, где x обозначает пиксельную информацию в момент времени t , а w представляет оцененный вектор потока. Тогда глобальные отклонения от предположения о постоянстве значения серого и от предположения о постоянстве градиента могут быть измерены с помощью энергии как

EData (u, v) = ∫ΩψI (x + w) −I (x) 2 + γ∇I (x + w) −∇I (x) 2dx,

(1)

где γ — вес между обоими предположениями.Применяется возрастающая вогнутая функция ψ (s2) = (s2 + ϵ2), что приводит к надежной оценке энергии [31], где ϵ — малая положительная константа, которая обычно устанавливается равной 0,001. Гладкость описывает предположение модели о кусочно-гладком поле течения и может быть выражено следующим образом:

ESmooth (u, v) = ∫Ωψ∇3u2 + ∇3v2dx.

(2)

Пространственно-временной градиент ∇3 = (δx, δy, δt) T указывает, что задействовано предположение пространственно-временной гладкости. Полная энергия представляет собой взвешенную сумму (1) и (2), и ее можно представить как

E (u, v) = EData + αESmooth,

(3)

где α — параметр регуляризации.Значение (u, v), которое минимизирует полную энергию, является оптимальным вектором потока.

Уравнение Эйлера – Лагранжа применяется к (3) для нахождения оптимального решения. Чтобы линеаризовать уравнение, Брокс применил численное приближение. Многомасштабный подход, также называемый пирамидой, и внутренний итерационный цикл применяются для подавления нелинейности оставшегося члена ψ [31]. Затем окончательное оптимальное уравнение преобразуется в матричную форму для всех пикселей в кадре изображения следующим образом:

(ψ ′) Datak, l · IxkIxk + γ (IxxkIxxk + IxykIxyk) IykIxk + γ (IyykIyxk + IxykIxyk) IxkIyk + γ (IxxkIxyk + IxykIyyk) IykIyk + γ (IyykIyyk + IxykIxyk) · duk, l + 1dvk, l + 1 = — (ψ ′) Datak, l · IxkItk + γ (IxxkIxtk + IxykIytk + IykIytk + IykIytk + IykIytk + α · div ((ψ ′) Smoothk, l∇3 (uk + duk, l)) div ((ψ ′) Smoothk, l∇3 (vk + dvk, l)),

(4)

где Ix, Iy, It, Ixx, Ixy, Ixt и Iyt представляют градиент для каждого направления; k — петля пирамиды; и -1 указывает цикл итераций для линеаризации в каждом цикле пирамиды [31].В (4) (ψ ′) Data и (ψ ′) Smooth получаются следующим образом:

(ψ ′) Datak, l = ψ ′ (Itk + Ixkduk, l + Iykdvk, l) 2 + γ (Ixtk + Ixxkduk, l + Ixykdvk, l) 2+ (Iytk + Ixykduk, l + Iyykdvk, l) 2,

(5)

(ψ ′) Smoothk, l = ψ′∇3 (uk + duk, l) 2 + ∇3 (vk + dvk, l) 2.

(6)

Если duk, l + 1 и dvk, l + 1 в левой части (4) обозначены как вектор w , оставшийся член как матрица A , а reight- сторона (4) как вектор b , то (4) может быть выражено как Aw = b, а окончательное решение для d может быть вычислено как

2.2. Модель гауссовой смеси

Алгоритм GMM, который был предложен Штауффером и Гримсоном [10], оценивает фоновое изображение, используя статистическую модель интенсивности для каждого пикселя в кадре изображения. Было проведено несколько работ по улучшению его производительности, и GMM получил широкое распространение в качестве базовой основы для создания фоновых моделей [11,12,13,14]. Поскольку алгоритм GMM, доступный в библиотеке программного обеспечения компьютерного зрения с открытым исходным кодом (OpenCV) [34], был оптимизирован с точки зрения производительности и сложности, он был принят в различных реализациях FPGA [35,36,37], а также применяется в предложенный нами алгоритм.

Алгоритм GMM состоит из смеси n гауссовских распределений, представленных тремя параметрами: весом ( w ), средним (μ) и дисперсией (σ2). Гауссовы распределения каждого пикселя имеют разные параметры и изменяются для каждого кадра изображения. Следовательно, эти параметры определяются тремя индексами, а именно i, n и t, где i — это индекс интенсивности пикселей, n — индекс для гауссовых распределений, а t — индекс, который относится к время рассматриваемого кадра.

Эти параметры обновляются по-разному в зависимости от условия соответствия, которое указывает, подходит ли пиксель для модели фона. Условие совпадения проверяется по распределению Гаусса n , которое моделирует пиксель, и задается следующим образом:

mn = 1, если | it − μn, t | 2≤D2 · σn, t2,

(8)

где D — порог, значение которого экспериментально выбрано равным 2,5. Фоновая модель каждого пикселя создается в диапазоне серого в диапазоне от 0 до 255 с использованием среднего значения и веса модели Гаусса следующим образом:

Bt = ∑k = 1Kwn, t · μn, t.

(9)

3. Предлагаемый алгоритм обнаружения движущихся объектов

Поскольку кадры изображения, полученные от движущихся камер, содержат движение как фона, так и объектов, предлагаемый алгоритм MOD выполняет процесс компенсации фона перед обнаружением объектов, как показано в . Процесс компенсации фона оценивает движение эго и генерирует компенсированный фон. Затем процесс обнаружения объекта извлекает координаты объекта с использованием текущего кадра изображения и скомпенсированного фона.Для минимизации шума используются два метода обнаружения, и окончательные координаты объекта определяются путем перекрестной проверки результатов. После согласования масштабов разрешения для двух выходных координат окончательный результат подтверждается операцией пересечения.

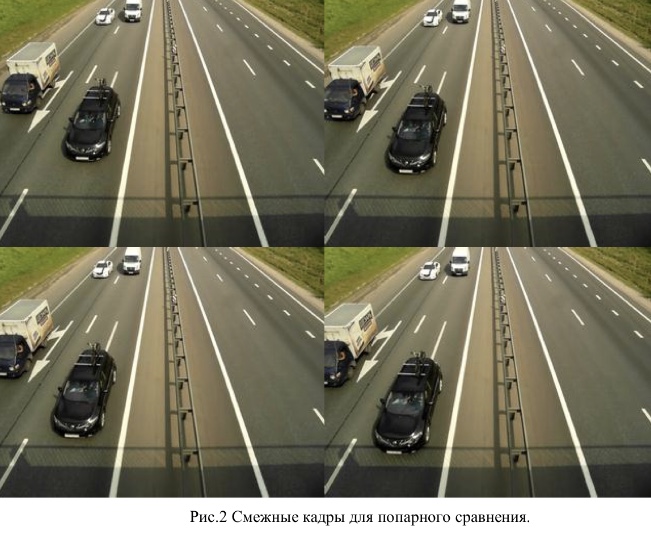

Общая схема предлагаемого алгоритма обнаружения движущихся объектов (MOD).

3.1. Компенсация фона

Чтобы оценить движение эго, алгоритм Brox OFE применяется к двум последовательным кадрам для извлечения векторов потока.Поскольку инверсия матрицы A в (7) требует времени вычисления, пропорционального размеру кадра изображения, а A является эрмитовой положительно определенной матрицей, мы применяем факторизацию Холецкого к A :

где L — нижняя треугольная матрица. Гораздо проще вычислить обратную треугольную матрицу [38], а обратную исходную матрицу можно вычислить простым умножением двух обратных величин следующим образом:

A − 1 = (L − 1) T (L − 1 ).

(11)

Затем окончательный вектор потока w вычисляется как

Извлеченный вектор потока для каждого пикселя представляет движение пикселя между последовательными кадрами. Пиксели в области фона имеют относительно медленное движение по сравнению с областью объекта. Кроме того, пиксели фона занимают большую площадь в кадре изображения, чем объекты, и демонстрируют аналогичное движение. Поэтому наиболее частый вектор потока с медленным движением рассматривается как движение эго, которое может быть извлечено с помощью анализа гистограммы.Затем ранее полученная фоновая модель компенсируется с использованием извлеченного эго-движения. В этом подходе фоновая модель выводится с помощью алгоритма GMM и сохраняется как параметры GMM.

После оценки эго-движения все параметры GMM могут быть сдвинуты назад по определенному движению, что приведет к созданию модели скомпенсированного фона. Сначала эго-движения edx и edy в направлениях оси x и оси y соответственно делятся на целую часть и дробную часть.Целые части edxi и edyi могут быть получены округлением edx и edy в большую сторону, тогда как дробные части edxf и edyf вычисляются как

Затем параметры GMM wn, t-1, μn, t-1 и σn, t-12 сдвигаются на edxi и edyi, как показано на. Пустое пространство, вызванное операцией сдвига для μn, t − 1, заполняется им той же позиции, как показано в a. С другой стороны, пустые пространства также заполняются заранее определенными значениями wo и σo2 для wk, t и σk, t2 соответственно, как показано на b, c.

Компенсация целых частей эго-движения. Заштрихованная область обозначает пустое пространство, созданное операцией сдвига: ( a ) μn, память t-1; ( b ) wn, t − 1 память; ( c ) σn, t − 12 память.

После этого параметры GMM интерполируются с использованием дробных частей эго-движения, а именно edxf и edyf. Интерполяция для edxf выполняется в направлении оси x, как показано в (15) — (17), и то же самое делается для edyf в направлении оси y, как показано в (18) — (20):

wn , t − 1x (x, y) = edxf · wn, t − 1 (x, y) + (1 − edxf) · wn, t − 1 (x + 1, y),

(15)

мкн , t − 1x (x, y) = edxf · μn, t − 1 (x, y) + (1 − edxf) · μn, t − 1 (x + 1, y),

(16)

σn , t − 1x (x, y) = edxf · σn, t − 12 (x, y) + (1 − edxf) · σn, t − 12 (x + 1, y),

(17)

wn , t (x, y) = edyf · wn, t − 1x (x, y) + (1 − edyf) · wn, t − 1x (x, y + 1),

(18)

μn, t (x, y) = edyf · μn, t − 1x (x, y) + (1 − edyf) · μn, t − 1x (x, y + 1),

(19)

σn, t2 (x , y) = edyf · σn, t − 1x (x, y) + (1 − edyf) · σn, t − 1x (x, y + 1).

(20)

После завершения процесса компенсации новые параметры GMM обновляются с помощью алгоритма GMM. Затем с помощью (9) создается окончательная модель фона, то есть модель скомпенсированного фона, с использованием wn, t, μn, t и σn, t2.

3.2. Обнаружение объекта

Чтобы извлечь координаты объекта в кадре изображения с использованием модели скомпенсированного фона, предложенный алгоритм MOD выполняет сначала операцию вычитания фона, а затем Brox OFE. Вычитание фона заключается в отделении движущихся объектов от неподвижных фоновых изображений.Если разница между моделью скомпенсированного фона и текущим кадром больше порогового значения, он классифицируется как движущийся объект, а остальное — как фон. Хотя этот подход может эффективно обнаруживать объекты, такое простое сравнение приводит к ложным срабатываниям.

Для решения этой проблемы выполняется Brox OFE между скомпенсированным фоном и текущим кадром для извлечения векторов потока всех пикселей. Извлеченные векторы потока, величина и направление которых отличаются от фоновых, могут быть сгруппированы в объекты.Чтобы сгруппировать области объекта из общих векторов в кадре, необходимо определить правильный порог. Этот порог следует выбирать для каждого кадра с учетом распределения векторов потока. Поскольку мы получили результаты обнаружения путем вычитания фона, окончательные результаты обнаружения определяются путем перекрестной проверки с обоими наборами результатов, чтобы уменьшить количество ложных срабатываний. Срединный фильтр результатов применяется для удаления относительно небольших объектов, например, вызванных шумом.

4. Проектирование аппаратной архитектуры

В этом разделе мы представляем аппаратную архитектуру предлагаемого детектора движущихся объектов для обработки в реальном времени. показывает блок-схему предлагаемого детектора движущихся объектов, который состоит из устройства оценки оптического потока, устройства оценки движения камеры, детектора фона и детектора объекта. Поток данных кадра изображения, поступающий из модуля внешней камеры, сохраняется во входных буферах кадра. Затем интенсивности пикселей двух последовательных кадров it-1 и it выбираются из этих буферов для оценки векторов потока ue и ve для, в свою очередь, оценки движения эго с помощью средства оценки оптического потока.Статистические данные гистограммы этих векторов потока анализируются устройством оценки движения камеры для извлечения эго-движений edx и edy. Для генерации скомпенсированного фона Bt детектор фона сдвигает параметры GMM в соответствии с оцененными движениями эго, как объяснено в разделе 3.1, и обновляет соответствующие параметры, применяя алгоритм GMM. Используя Bt и интенсивности пикселей текущего кадра it, детектор объектов выполняет вычитание фона, а модуль оценки оптического потока одновременно извлекает новые векторы потока uo и vo.Эти векторы потока используются детектором объекта для классификации области объекта. Наконец, координаты объекта генерируются путем объединения двух наборов результатов обнаружения.

Блок-схема предлагаемого детектора движущихся объектов.

4.1. Устройство оценки оптического потока

Устройство оценки оптического потока, показанное на a, состоит из блока свертки (CU) для предварительной обработки, блока обработки разрешения (RPU) для вычисления решения уравнения Эйлера-Лагранжа, блока деформации и выходной блок решения.Поскольку требуется многомасштабный подход (также называемый пирамидой), входные кадры масштабируются до более низкого разрешения после сглаживания по Гауссу. Затем модуль градиентной фильтрации вычисляет Ix, Iy, It, Ixx, Ixy, Ixt и Iyt, используя масштабированные кадры изображения. Операции сглаживания по Гауссу, масштабирования изображения и градиентной фильтрации сгруппированы в CU и имеют общую структуру в калькуляторе свертки для уменьшения сложности оборудования. Это возможно, потому что они выполняют аналогичные операции фильтрации изображений.Использование этой разделяемой структуры уменьшает количество умножителей на десять, сумматоров на пять и линейных буферов на четыре, как показано на b. После завершения градиентной фильтрации RPU вычисляет (4) для извлечения векторов потока. Затем блок деформирования генерирует кадры изображения с более высоким разрешением, используя ранее масштабированные данные и извлеченные векторы потока. Общая операция блока оценки оптического потока повторяется во время цикла пирамиды.