Что делать, если нет данных в базе РСА либо указаны неправильные?

Содержание страницы

С 2013 года Союзом автостраховщиков РФ (РСА) введена в работу база данных, используемая при проверке коэффициента «бонус-малус» (КБМ). Указанный параметр в обязательном порядке должен использоваться страховыми компаниями при расчете тарифа по страхованию (ОСАГО).

Учитывая собственную страховую историю, водители могут рассчитывать на понижение тарифа за счет бонусов (5% за каждый год) за безаварийное вождение в предыдущий страхованию год. Если в ходе последних двух лет имело место ДТП по вине клиента, то размер тарифа увеличивается (малус).

В чем преимущества метода?

Для клиента выгода от единой базы данных состоит в том, что стоимость полиса должна ему объявляться сотрудником СК только после выполнения запроса в базу РСА и выявления права на получение скидки по стоимости. Ранее расчет часто производился по базовому тарифу без учета имеющегося бонуса.

Для страховой компании положительным моментом является возможность получения реальной картины по водительской истории клиента.

Почему нет сведений в базе?

Персональные данные в единой страховой базе могут отсутствовать по нескольким причинам:

- когда страховая компания по разным причинам не передала информацию об истории вождения клиента;

- когда переданы не правильные данные в РСА, а с ошибками, поэтому они не привязаны в базе к конкретному водителю;

- когда произошел технический сбой в работе программы и какие-то участки с данными оказались поврежденными;

- когда клиент произвел обмен водительского удостоверения, но информация в базе осталась привязанной к устаревшим данным;

- когда клиент только получил права и оформляет самый первый страховой договор.

Что делать при отсутствии информации в базе РСА?

Чтобы убедиться в том, что действительно нет данных в РСА о КБМ, следует направить письменный запрос в Союз автостраховщиков. Если не найдут подтверждения факты передачи сведений страховщиками за предыдущие периоды, водитель должен предпринять следующие действия:

- Подготовить старые страховые полисы ОСАГО. При их отсутствии обратиться в СК, где ранее оформлялись договора, и выяснить номера документов, период их действия и дату выдачи.

- По месту оформления предыдущего полиса получить справку для перехода в другую СК с указанием данных о страховом стаже клиента и страховых случаях (если таковые были).

- Полученную справку отнести в СК, где планируется оформление нового страхового соглашения.

Если договор уже оформлен, то на основании предоставленной справки стоимость полиса должна быть пересчитана, и возвращена часть оплаченной премии при наличии права на скидки (по КБМ).

Застраховать с ошибками: что показал новый сервис по проверке ОСАГО | Статьи

Автовладельцы могут получить штраф или вообще лишиться страховой выплаты, если при оформлении ОСАГО были указаны неверные данные. Так поступают недобросовестные посредники с целью оформить полис дешевле, а с автовладельца получить обычную сумму. Российский союз автостраховщиков (РСА) запустил сервис, с помощью которого автовладельцы самостоятельно могут проверить указанные в базе АИС ОСАГО сведения. Что делать, если в полисе обнаружились ошибки, разбирались «Известия».

Так поступают недобросовестные посредники с целью оформить полис дешевле, а с автовладельца получить обычную сумму. Российский союз автостраховщиков (РСА) запустил сервис, с помощью которого автовладельцы самостоятельно могут проверить указанные в базе АИС ОСАГО сведения. Что делать, если в полисе обнаружились ошибки, разбирались «Известия».

Пробить по базе

Раньше на сайте РСА можно было проверить, является ли полис действующим на момент ДТП. С помощью нового сервиса автовладелец сможет узнать, какие именно параметры были указаны при оформлении полиса — марка, модель и категория транспортного средства, мощность, узнать коэффициент бонус-малус, регион использования автомобиля, количество водителей, допущенных к управлению, и т.д. И, естественно, его цену.

В РСА сообщили «Известиям», что ограничились добавлением ключевых параметров, которые обычно искажаются недобросовестными посредниками и существенно влияют на цену полиса ОСАГО.

Что показала проверка

Кроме того, в сервисе указаны собственник и страхователь транспортного средства. И хотя все буквы, кроме первой, закрыты звездочками, имя, отчество и год рождения позволяют сопоставить указанных в остальных документах лиц. Это, как и срок действия страховки, важная информация, если ДТП уже произошло и у вас есть сомнения относительно другого участника аварии.

И хотя все буквы, кроме первой, закрыты звездочками, имя, отчество и год рождения позволяют сопоставить указанных в остальных документах лиц. Это, как и срок действия страховки, важная информация, если ДТП уже произошло и у вас есть сомнения относительно другого участника аварии.

Между тем проверка редакцией «Известий» девяти машин и одного мотоцикла оставила много вопросов. Например, корректный результат дает поиск по серии и номеру полиса, а также по VIN автомобиля. Если искать по госномеру, система в большинстве случаев ничего не находит либо отображает данные старого полиса и прежних владельцев машины.

Фото: ИЗВЕСТИЯ/Зураб Джавахадзе

Автоэксперт Игорь Моржаретто считает, что новый сервис еще будут дорабатывать, и положительно оценил его появление.

«Только когда покупаешь новый полис, выясняется, что у тебя странный какой-то КБМ. Начинаешь выяснять самостоятельно, а для этого нужен источник информации, нужна обратная связь, где я могу сказать: «Вы, ребята, неправы, у меня по-другому», — рассказал он.

Без номера и категории

Обычно госномер не попадает в базу, если автовладелец оформил ОСАГО до того, как поставил автомобиль на учет в ГИБДД. Однако у единственного проверенного мотоцикла не оказалось ни госномера, хотя транспортное средство было поставлено на учет, ни марки и модели, ни мощности. А в качестве категории было указано загадочное: «0 Прочее (категория «с»)». Даже в РСА не смогли объяснить этот термин. В Союзе пообещали дать ответ технического специалиста, но на момент сдачи материала комментарий не предоставили.

Фото: ИЗВЕСТИЯ/Дмитрий Коротаев

Отсутствие госномера автомобиля в базе теоретически грозит добросовестному автовладельцу штрафом, когда автоматическая проверка ОСАГО с помощью камер будет запущена. Проблемы могут возникнуть, подтвердили в РСА и попросили всех, получивших полис ОСАГО до регистрации ТС, сообщить в свою страховую компанию о присвоенном автомобилю госномере.

Внимание, работают мошенники

РСА и страховщики фиксирует большое количество попыток оформить полис ОСАГО с недостоверными сведениями.

«В данном случае стоит говорить о недобросовестных «посредниках», которые, используя незнание автовладельцев, оформляют полис ОСАГО онлайн и вводят недостоверные сведения, например цель использования, мощность и т.д., снижают стоимость полиса, а затем передают клиенту иной полис с иной стоимостью, разницу присваивая себе.

В практике «Согласия» есть такие прецеденты, подобные действия «посредников» носят мошеннический характер и наносят вред потребителю и репутации страховщика», — рассказала «Известиям» директор судебно-правового департамента страховой компании «Согласие» Анна Полина-Сташевская. И посоветовала оформлять полис е-ОСАГО, не требующий привлечения посредников.Президент РСА Игорь Юргенс отметил, что в настоящее время в системе АИС ОСАГО 2.0 работают фильтры, позволяющие отсеивать попытки оформить полис ОСАГО, указав при оформлении заведомо неверные данные.

Офис страховой компании

Фото: ТАСС/Сергей Николаев

«Однако никакие технические решения не могут на 100% защитить от мошенничества», — отметил он.

И действительно, в одном из проверенных «Известиями» полисов в графе «Цель использования» было указано «Учебная езда», хотя машина используется в личных целях. Почему посредник указал ее при оформлении полиса — загадка.

«Указание в графе «Цель использования» варианта «Учебная езда» в настоящее время не влияет на формирование страховой премии по ОСАГО, а также на получение страховой выплаты в случае страхового события. Однако стоит быть внимательным, возможны случаи, когда похожая ошибка может привести к регрессу. Например, если у автомобиля есть лицензия такси, но в страховом полисе указано, что транспортное средство используется для личных целей, в случае аварии страховая компания может выставить регресс лицу, причинившему вред», — рассказали в пресс-службе «Альфастрахования». Кроме того, если полис окажется оформленным на другую машину или другого страхователя, пострадавшему в ДТП вообще могут отказать в страховой выплате.

Ваш полис недействителен

Какой процент неверных сведений в полисе сделает его недействительным? Для договоров ОСАГО нет такого понятия — «процент неправильно указанных данных», уточнили в РСА. В Союзе добавили, что в каждом конкретном случае необходимо разбираться, была ли допущена опечатка или случайная ошибка либо данные были введены заведомо неверно.

В Союзе добавили, что в каждом конкретном случае необходимо разбираться, была ли допущена опечатка или случайная ошибка либо данные были введены заведомо неверно.

Федеральный закон об ОСАГО, Положение о правилах ОСАГО не содержат в себе указаний о проценте неправильных сведений, содержащихся в полисе ОСАГО, чтобы признать его недействительным, отметил ведущий юрист Европейской юридической службы Орест Мацала. По его словам, чтобы досрочно прекратить действие договора ОСАГО либо вовсе признать его недействительным, необходимо установить, что недостоверные сведения были представлены намеренно и это повлекло за собой необоснованное снижение стоимости ОСАГО.

Фото: ТАСС/Ведомости/Евгений Разумный

«Любые недостоверные сведения, которые непосредственно повлияли на размер страховой премии, позволяют страховщику досрочно прекратить договор страхования либо в дальнейшем предъявить регрессные требования в соответствии со ст. 14 закона об ОСАГО.

Пишите письма

Что делать, если при проверке полиса ОСАГО в базе обнаружились неверные сведения? Следует обратиться в страховую компанию и написать письменное заявление, чтобы изменения в договоре были сделаны. Если установлено, что имело место мошенничество, эксперты и страховщики рекомендуют обратиться и в правоохранительные органы.

Кроме того, у автовладельца есть шанс получить компенсацию через суд, считает Орест Мацала.

«Поскольку страхование ОСАГО — это услуга, при некачественно оказанной услуге, в том числе и при заключении договора, можно требовать компенсации всех убытков и возмещения морального вреда в соответствии со ст. 15 и 29 закона «О защите прав потребителей», — отметил ведущий юрист Европейской юридической службы.

15 и 29 закона «О защите прав потребителей», — отметил ведущий юрист Европейской юридической службы.

Не прошел проверку РСА. Что делать? » 711.ru

Зачем нужна проверка РСА

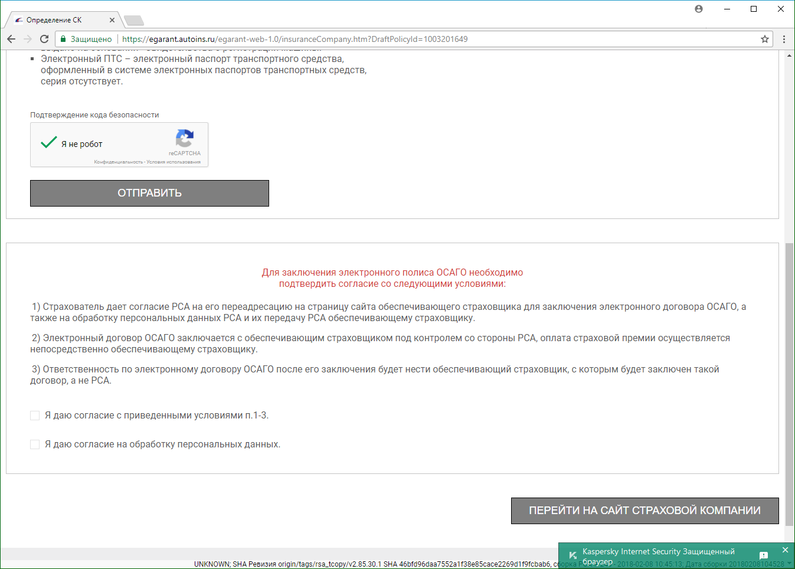

Проверка РСА в электронных полисах ОСАГО — обязательная процедура. Вы вводите информацию о своем автомобиле, себе (паспортные данные) и водителях, которые будут допущены к управлению. Страховая компания в зашифрованном виде отправляет эти сведения в базу данных РСА.

Проверка по базе РСА проходит в автоматическом режиме. Ее основная цель — проверить были ли у вас раньше полисы, какая по ним страховая история (количество аварий) и корректно рассчитать стоимость полиса.

Когда происходит проверка

Проверка по базе РСА запускается после того, как вы заполнили заявление на страхование для электронного полиса ОСАГО в личном кабинете на сайте страховой компании.

Без положительного прохождения проверки, вы не сможете перейти к оплате полиса.

Почему не проходит проверка РСА

Проверка не всегда проходит успешно. Нередко система страховщика не может выполнить ее.

Нередко система страховщика не может выполнить ее.

Причины непрохождения бывают разные. Технический сбой, отсутствие в базе информации по вам и вашей машине — самые распространенные из них.

Иногда встречается намеренная блокировка результатов проверки. Недобросовестные компании таким образом пытаются регулировать поток клиентов и отсеивать невыгодных — из “токсичных” регионов и с убытками по прошлым годам. Подобные действия запрещены и могут привести к болезненным санкциям для страховщиков со стороны РСА и ЦБ РФ.

Что делать, если не прошла проверка РСА

При оформлении электронного полиса ОСАГО на сайте страховой компании вам могут сообщить, что автоматическая проверка РСА не прошла.

Например, в Росгосстрахе это выглядит так:

Чтобы исправить ситуацию, вам предложат загрузить на сайт электронные копии следующих документов:

- паспорт страхователя — основная страница и страница с пропиской;

- паспорт транспортного средства — обе стороны;

- диагностическая карта;

- водительское удостоверение — обе стороны.

Безопасно ли это? Вполне. Доступ в личный кабинет для оформления Е-ОСАГО происходит по защищенному протоколу https (на всякий случай проверьте это в адресной строке браузера). Информация по документам попадет только в страховую компанию, которая не имеет права передавать ее третьим лицам.

Специалисты страховщика вручную проверят в базе данных РСА ваши данные по документам. И в течение 30 минут минут пришлют на электронную почту дальнейшие инструкции. От компании к компании время варьируется, но в среднем ждать дольше получаса не придется.

Результат ручной проверки в компании

Результатом ручной проверки документов сотрудниками страховой компании станет письмо.

К примеру, от Росгосстраха, приходит письмо следующего содержания.

В письме вам сообщат, что по документам у вас все в порядке, и вы всё правильно заполнили в заявлении на Е-ОСАГО.

Здесь же будет ссылка для входа в личный кабинет и продолжения оформления электронного полиса.

Для удобства клиентов, все данные, введенные в личном кабинете, сохраняются. Включая информацию по страхователю, автомобилю и водителям.

Останется только перейти в раздел оплаты и оплатить полис банковской картой.

Евгений Попков / 711.ru

Поделиться статьей:

Как восстановить КБМ в 2021 году? Как вернуть КБМ по ОСАГО после замены прав

Этапы восстановления КБМ

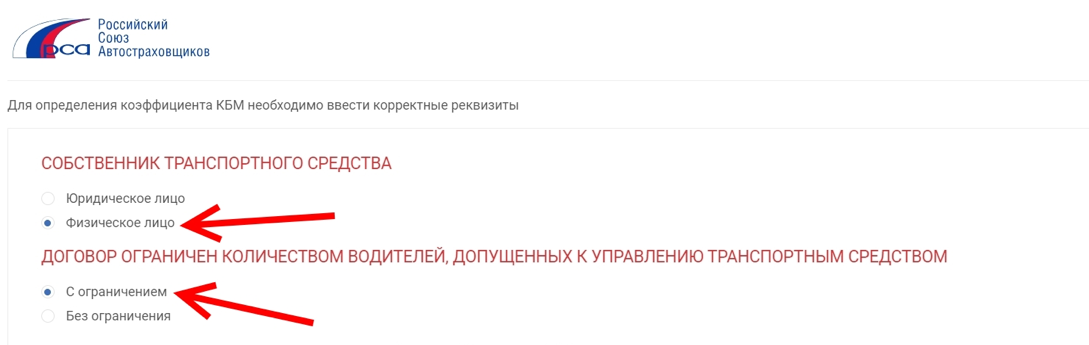

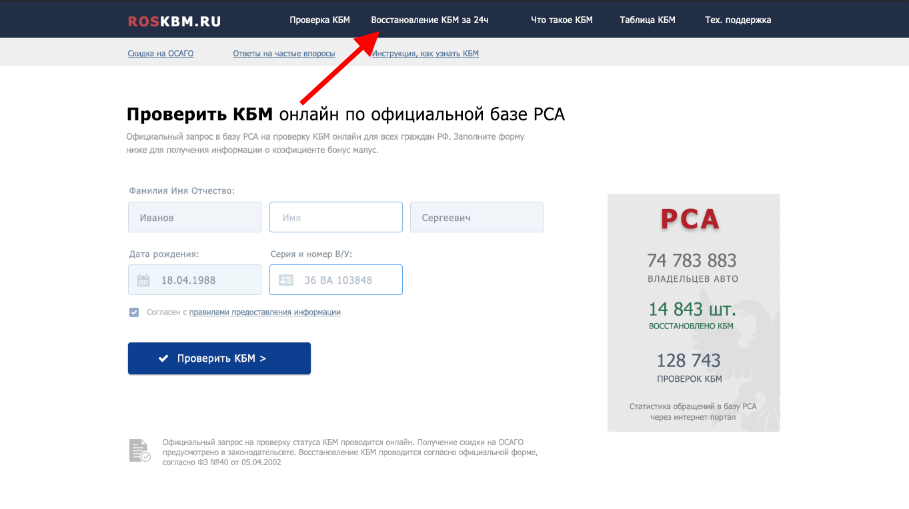

Первым этапом, чтобы восстановить КБМ, по базе РСА надо узнать самостоятельно свой коэффициент. Сервис бесплатный, в режиме онлайн на нём введите информацию о себе: ФИО, дату рождения и данные водительского удостоверения. После обработки выйдет информация обо всех изменениях показателя, по которым вы сможете отследить, где произошел сбой. Определив, в какой страховой компании ваш коэффициент завысили, вы сохраняете историю изменений вашего КБМ.

Далее отправляйте заявление в страховую компанию для проведения проверки и осуществления перерасчета на основании приложенных данных. При необходимости прикладывайте:

- справку из предыдущей страховой компании об отсутствии выплат по ущербу;

- документы, подтверждающие смену фамилии;

- копии старого и нового водительского удостоверения;

- предыдущий полис ОСАГО.

На рассмотрение заявления отводится 15 дней.

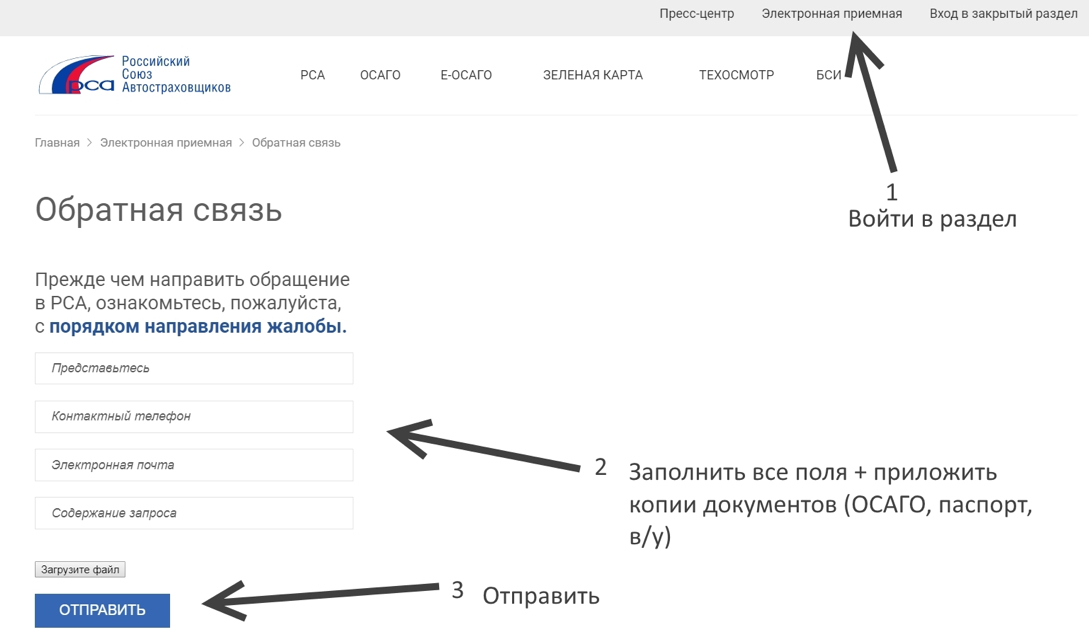

Как вернуть КБМ, если этот способ не сработал, или страховщик, который допустил оплошность, уже ликвидирован? Обращайтесь с жалобой в РСА и ЦБ. Заявления в данные инстанции можно также подавать в письменном или электронном виде, заполнив соответствующие формы на сайте. Список прилагаемых документов для подачи жалобы тот же, что и в предыдущем случае. При этом вам нужно указать страховую компанию, описать, с каким КБМ оформлялись полисы, и указать количество аварий в период страхования, а также приложить свое обращение в страховую компанию и ответ на него, если таковой последовал. Эта процедура занимает от до 60 дней.

При этом вам нужно указать страховую компанию, описать, с каким КБМ оформлялись полисы, и указать количество аварий в период страхования, а также приложить свое обращение в страховую компанию и ответ на него, если таковой последовал. Эта процедура занимает от до 60 дней.

После восстановления КБМ вы сможете пересчитать стоимость полиса и вернуть излишне оплаченные суммы, обратившись в страховую компанию.

Оформить полисКуда исчезает скидка на ОСАГО

Политика конфиденциальности

Введение

Мы стремимся уважать информацию личного характера, касающуюся посетителей нашего сайта. В настоящей Политике конфиденциальности разъясняются некоторые из мер, которые мы предпринимаем для защиты Вашей частной жизни.

Конфиденциальность информации личного характера

«Информация личного характера» обозначает любую информацию, которая может быть использована для идентификации личности, например, фамилия или адрес электронной почты.

Использование информации частного характера.

Информация личного характера, полученная через наш сайт, используется нами, среди прочего, для целей регистрирования пользователей, для поддержки работы и совершенствования нашего сайта, отслеживания политики и статистики пользования сайтом, а также в целях, разрешенных вами.

Раскрытие информации частного характера.

Мы нанимаем другие компании или связаны с компаниями, которые по нашему поручению предоставляют услуги, такие как обработка и доставка информации, размещение информации на данном сайте, доставка содержания и услуг, предоставляемых настоящим сайтом, выполнение статистического анализа. Чтобы эти компании могли предоставлять эти услуги, мы можем сообщать им информацию личного характера, однако им будет разрешено получать только ту информацию личного характера, которая необходима им для предоставления услуг. Они обязаны соблюдать конфиденциальность этой информации, и им запрещено использовать ее в иных целях.

Мы можем использовать или раскрывать Ваши личные данные и по иным причинам, в том числе, если мы считаем, что это необходимо в целях выполнения требований закона или решений суда, для защиты наших прав или собственности, защиты личной безопасности пользователей нашего сайта или представителей широкой общественности, в целях расследования или принятия мер в отношении незаконной или предполагаемой незаконной деятельности, в связи с корпоративными сделками, такими как разукрупнение, слияние, консолидация, продажа активов или в маловероятном случае банкротства, или в иных целях в соответствии с Вашим согласием.

Мы не будем продавать, предоставлять на правах аренды или лизинга наши списки пользователей с адресами электронной почты третьим сторонам.

Доступ к информации личного характера.

Если после предоставления информации на данный сайт, Вы решите, что Вы не хотите, чтобы Ваша Персональная информация использовалась в каких-либо целях, Вы можете исключить себя из списка ОНЭКСИМ, связавшись с нами по следующему адресу: info@ur29. ru

ru

Наша практика в отношении информации неличного характера.

Мы можем собирать информацию неличного характера о Вашем посещении сайта, в том числе просматриваемые вами страницы, выбираемые вами ссылки, а также другие действия в связи с Вашим использованием нашего сайта. Кроме того, мы можем собирать определенную стандартную информацию, которую Ваш браузер направляет на любой посещаемый вами сайт, такую как Ваш IP-адрес, тип браузера и язык, время, проведенное на сайте, и адрес соответствующего веб-сайта.

Использование закладок (cookies).

Файл cookie — это небольшой текстовый файл, размещаемый на Вашем твердом диске нашим сервером. Cookies содержат информацию, которая позже может быть нами прочитана. Никакие данные, собранные нами таким путем, не могут быть использованы для идентификации посетителя сайта. Не могут cookies использоваться и для запуска программ или для заражения Вашего компьютера вирусами. Мы используем cookies в целях контроля использования нашего сайта, сбора информации неличного характера о наших пользователях, сохранения Ваших предпочтений и другой информации на Вашем компьютере с тем, чтобы сэкономить Ваше время за счет снятия необходимости многократно вводить одну и ту же информацию, а также в целях отображения Вашего персонализированного содержания в ходе Ваших последующих посещений нашего сайта. Эта информация также используется для статистических исследований, направленных на корректировку содержания в соответствии с предпочтениями пользователей.

Эта информация также используется для статистических исследований, направленных на корректировку содержания в соответствии с предпочтениями пользователей.

Агрегированная информация.

Мы можем объединять в неидентифицируемом формате предоставляемую вами личную информацию и личную информацию, предоставляемую другими пользователями, создавая таким образом агрегированные данные. Мы планируем анализировать данные агрегированного характера в основном в целях отслеживания групповых тенденций. Мы не увязываем агрегированные данные о пользователях с информацией личного характера, поэтому агрегированные данные не могут использоваться для установления связи с вами или Вашей идентификации. Вместо фактических имен в процессе создания агрегированных данных и анализа мы будем использовать имена пользователей. В статистических целях и в целях отслеживания групповых тенденций анонимные агрегированные данные могут предоставляться другим компаниям, с которыми мы взаимодействуем.

Изменения, вносимые в настоящее Заявление о конфиденциальности.

Мы сохраняем за собой право время от времени вносить изменения или дополнения в настоящую Политику конфиденциальности — частично или полностью. Мы призываем Вас периодически перечитывать нашу Политику конфиденциальности с тем, чтобы быть информированными относительно того, как мы защищаем Вашу личную информацию. С последним вариантом Политики конфиденциальности можно ознакомиться путем нажатия на гипертекстовую ссылку «Политика конфиденциальности», находящуюся в нижней части домашней страницы данного сайта. Во многих случаях, при внесении изменений в Политику конфиденциальности, мы также изменяем и дату, проставленную в начале текста Политики конфиденциальности, однако других уведомлений об изменениях мы можем вам не направлять. Однако, если речь идет о существенных изменениях, мы уведомим Вас, либо разместив предварительное заметное объявление о таких изменениях, либо непосредственно направив вам уведомление по электронной почте. Продолжение использования вами данного сайта и выход на него означает Ваше согласие с такими изменениями.

Продолжение использования вами данного сайта и выход на него означает Ваше согласие с такими изменениями.

Связь с нами.

Если у Вас возникли какие-либо вопросы или предложения по поводу нашего положения о конфиденциальности, пожалуйста, свяжитесь с нами по следующему адресу: [email protected]

Как проверить подлинность страхового полиса ОСАГО?

Содержание статьи:

Страховой рынок всегда привлекал мошенников. Чтобы не стать их жертвой, автовладельцам не следует терять бдительность

и обязательно проверять подлинность страхового полиса. В случае с полисом обязательного страхования гражданской

ответственности владельцев транспортных средств (ОСАГО), сделать это можно с помощью единой автоматизированной

информационной системы Российского союза автостраховщиков (РСА), в которой фиксируются все договоры «автогражданки».

Именно участившиеся случаи подделки бланков ОСАГО, использование мошенниками утраченных полисов, а также страховок уже

не существующих компаний, у которых была отозвана лицензия, привели к тому, что РСА разработал федеральную систему для

проверки их подлинности.

ОСАГО

Покупая полис ОСАГО, обратите внимание на размер бланка (он больше формата А4 примерно на 1 см), на наличие водяных знаков защиты с логотипом РСА. Кроме того, на бланке должны быть разноцветные ворсинки, а по левому краю проходить металлическая полоска. Номер оригинального полиса содержит 3 буквы (серия договора) и 10 цифр (номер бланка строгой отчетности – БСО). При этом, все цифры на бланке – выпуклые. Для бумажных полисов ОСАГО сейчас действует серия РРР/ННН.

Очень важно, чтобы сумма страховой премии в договоре совпадала с суммой денег, которую вы платите за полис. Конечно, при оплате вам обязаны выдать квитанцию.

Фальшивые бланки

Поддельные полисы ОСАГО злоумышленники изготавливают специально или воруют у страховой компании, но такие случаи очень редки. Крупные страховые компании серьезно следят за сохранностью ОСАГО, бумажная версия которых является бланками строгой отчетности (БСО).

Также поддельными являются бланки, которые принадлежат страховой компании с отозванной лицензией на ведение страховой

деятельности.

Проверка на подлинность. База РСА

База РСА бесплатная и доступна абсолютно всем автовладельцем на официальном сайте организации — https://autoins.ru/. Проверить подлинность ОСАГО просто: перейдите в одноименную вкладку, выбрав после этого опцию «Проверка полиса». Вам не потребуются ни авторизация, ни регистрация, только сведения из документа, который есть у вас на руках или в электронном виде. Система обрабатывает данные и выдает результат мгновенно.

Мобильное приложение «Помощник ОСАГО»

В прошлом году в нескольких пилотных регионах заработало мобильное приложение «Помощник ОСАГО». В ноябре 2020 года мобильное приложение доступно для автовладельцев со всех уголков России. Один из создателей «Помощника ОСАГО» — РСА, поэтому проверить полис ОСАГО на подлинность в приложении так же просто, как и на официальном сайте организации. Скачать приложение можно в AppStore и Google Play.

Гос. номер, VIN код, номер кузова и шасси автомобиля

Проверить полис ОСАГО на подлинность с помощью VIN-номера, государственного регистрационного знака, номера кузова и

шасси автомобиля важно для тех, кто хочет купить машину. Такой способ проверки подлинности полиса наиболее полный, вы

получите информацию – действителен ли полис ОСАГО, кто вписан в него (если тип страховки ограничен).

Такой способ проверки подлинности полиса наиболее полный, вы

получите информацию – действителен ли полис ОСАГО, кто вписан в него (если тип страховки ограничен).

https://autoins.ru/ -> ОСАГО -> Проверка полиса ОСАГО -> Реквизиты транспортного средства.

Результаты запроса в базу РСА

Сведения, полученные в базе РСА, гарантированно достоверные. Все дело в том, что в единую систему вносить данные могут только страховые компании. Особенно важно обращаться к проверенным страховщиком, давно работающим на страховом рынке и зарекомендовавшим себя.

Если вы столкнулись с мошенниками, то при проверке полиса, вы увидите сообщения – «Утратил силу» или «Утерян». Такие статусы свидетельствуют о том, что договор недействителен.

В отношении подлинных полисов «автогражданки» система выдает статусы – «Находится у страховщика» (если вы купили

полис, но менеджер компании пока не успел внести данные в базу РСА) или «Находится у страхователя».

Статус «Находится у страхователя» – самый правильный. Обратите внимание, что срок страхования и название страховой компании должны совпадать с данными, которые содержаться в договоре. К сожалению, если мошенники продали вам дубликат страхового полиса, то вы тоже увидите статус «Находится у страхователя». Проверьте на сайте РСА, какая машина застрахована по полису и имейте ввиду, что полис – дубликат от мошенников, если сведения не совпали.

Если ваш полис «Находится у страховщика» и уже довольно давно, стоит связаться с компанией с просьбой прояснить ситуацию.

Проверка не дала результатов. Что делать?

Скорее всего, вы столкнулись со злоумышленниками. Для начала свяжитесь со страховой компанией, указанной в полисе.

Электронный полис ОСАГО

Е-ОСАГО – выбор многих современных людей. Полис электронный, но защита по нему реальная, полис равноценен бумажной

версии. Однако электронный полис не убережет от мошенников, которые подделывают даже сайты, предлагая водителям

приобрести ОСАГО.

Покупайте полисы на официальных сайтах страховых компаний. Обратите внимание, что серия полисов е-ОСАГО начинается с XXX.

Заключение

Если вы столкнулись с мошенниками, обратитесь в полицию. Пишите заявление и требуйте завести уголовное дело, приложив доказательства того, что ваш полис ОСАГО – поддельный.

Надежные страховые компании дорожат своей репутацией. Как правило, вопросы с поддельными бланками ОСАГО решаются на уровне службы безопасности страховой компании. Обращайтесь к проверенным страховщикам, оформляйте договор в официальных офисах продаж страховых компаний, онлайн на сайтах страховщиков, обращайте внимание на наличие агентского договора у страхового представителя и проверяйте его подлинность, позвонив в компанию. Будьте спокойны за то, что ваш полис ОСАГО – действительный.

Как восстановить КБМ в РСА

Нередки ситуации допущения ошибок в расчетах стоимости полиса ОСАГО, когда страховщик забывает или неверно определяет коэффициент водителя за безаварийную езду. Чтобы избежать завышенной оплаты, вы можете сами контролировать показатель скидки, периодически отправляя заявку на проверку КБМ по инструкции на сайте: https://roskbm.ru/kak-uznat-kbm.

Чтобы избежать завышенной оплаты, вы можете сами контролировать показатель скидки, периодически отправляя заявку на проверку КБМ по инструкции на сайте: https://roskbm.ru/kak-uznat-kbm.

Почему скидка на ОСАГО пропала

Нередки случаи, когда при проверке КБМ обнаруживается пропажа или значительное уменьшение скидки на страховой полис. Если вам вернули стандартный класс и КБМ=1, нужно разобраться в причинах и исправить ситуацию.

Как накопить КБМ на скидку

- Год безаварийной езды дает скидку 5% и повышает класс на один.

Если с момента последнего страхования автомобиля прошло менее 12 месяцев, скидка не положена. Аналогично происходит и в случаях вписывания третьих лиц (жены, друга) в страховку в середине срока действия полиса.

-

Скидка на полис действует при непрерывном страховании автогражданской ответственности.

После прекращения действия страхового договора скидка остается только на год. Если перерыв в страховании дольше 12 месяцев, дисконт сгорает, нужно начинать копить КБМ с начала.

- Максимальный размер скидки 50 % достигается спустя 10 лет непрерывного вождения без аварий по вине водителя – это самый последний, 13 класс.

После достижения последнего класса последующие классы будут тоже под значением 13, пока вы не попадаете в аварию, и класс не снизится.

Ошибки в запросе на проверку КБМ

Часто ошибочный ответ на запрос выпадает при введении ошибочных данных владельца автомобиля. Если вы поменяли фамилию, в базе содержатся старые данные: обратите внимание на поле «Старая фамилия, если меняли» на странице заполнения формы для восстановления КБМ. Попробуйте ввести старые данные, и тогда увидите действующий КБМ и размер скидки на ОСАГО.

Аналогичная ситуация в случае с заменой водительских прав: введите номер прежнего водительского удостоверения (его можно узнать в разделе «Особые отметки» нового документа) и отправьте запрос.

Ошибка в КБМ по другим полисам

Иногда друзья и родственники вписывают друг друга в страховку на автомобиль, и если это ваш случай, стоит проверить значения КБМ в каждом из полисов, где значится ваша фамилия.

Ошибка могла произойти на стадии расчетов полиса другого человека, когда страховой агент случайно обнуляет скидки по всем полисам с одной фамилией, а владельцы машин не обращают внимания на ее отсутствие. В итоге вы попадаете в базу РСА с обнуленной скидкой, которую придется восстановить. При заполнении формы на проверку КБМ можно проверить, какой страховой полис утратил скидку.

Ошибки в КБМ в базе РСА онлайн

При возникновении проблем с расчетом скидки на ОСАГО страховщики любят ссылаться на ошибки в официальной базе РСА. Но часто это происходит именно по вине страхового агента, который вносит ваши данные в базу с ошибкой.

Дата рождения, фамилия, номер и серия водительского удостоверения – малейшая опечатка в этих сведениях приводит к нулевой скидке и начальному КБМ. Иногда в действиях страховщиков имеется прямой умысел: занесение данных с незаметной опечаткой – буква О вместо цифры 0 в дате рождения – не отображается в полисе ОСАГО и не может быть проверено вами на месте. Обнаружить ошибку можно при запросе справки о безубыточности, где указаны все данные из базы РСА.

Иногда в действиях страховщиков имеется прямой умысел: занесение данных с незаметной опечаткой – буква О вместо цифры 0 в дате рождения – не отображается в полисе ОСАГО и не может быть проверено вами на месте. Обнаружить ошибку можно при запросе справки о безубыточности, где указаны все данные из базы РСА.

Поддельный полис ОСАГО

Если вы страховали автомобиль на сайте непроверенного страховщика, есть риск приобрести липовую страховку. В таком случае естественно, что данные страхового полиса не отображаются в базе РСА – потому что их нет. Также сведения о страховании могут отсутствовать, если страховщик не передал их в базу. Сегодня случаи утраты договора практически исключены, потому что заключение оформляется на компьютере, а не вручную. Но если агент выписал бумажный вариант полиса и случайно утратил его по дороге в страховую, в базу РСА вы вряд ли попадете.

Намеренное сокрытие скидки ОСАГО

Страхование – доходный бизнес, и потому понятно желание страхового агента продать полис подороже. Нередки ситуации намеренного скрывания скидки от страхователя с целью получения крупной комиссии. Финансовая безграмотность клиентов страховой компании играет на руку нечистоплотным страховщикам. Вас могут обмануть сообщением об отсутствии связи с базой РСА или зависании компьютера. Поэтому следует заранее выяснить свой КБМ и положенную скидку, чтобы с этими сведениями идти страховать личный автомобиль.

Нередки ситуации намеренного скрывания скидки от страхователя с целью получения крупной комиссии. Финансовая безграмотность клиентов страховой компании играет на руку нечистоплотным страховщикам. Вас могут обмануть сообщением об отсутствии связи с базой РСА или зависании компьютера. Поэтому следует заранее выяснить свой КБМ и положенную скидку, чтобы с этими сведениями идти страховать личный автомобиль.

Как вернуть скидку на ОСАГО

Коэффициент бонус-малус влияет на конечную сумму по оплате страхового полиса. Размер КБМ зависит от количества лет, в течение которых у водителя отсутствовали ДТП по его вине. Чем идеальнее водительская история, тем выше скидка на ОСАГО, которая может достигать 50% в зависимости от тарифа КБМ. Вы можете ознакомиться с таблицей КБМ 2020 года и узнать свой тариф по ссылке: https://roskbm.ru/kbm-tablica.

Введение коэффициента для расчета стоимости полиса стимулирует водителя на аккуратную, безаварийную езду. Если за 10 лет стажа вы не попали ни в одну аварию, полис ОСАГО будет стоить в два раза меньше обычной цены.

Если за 10 лет стажа вы не попали ни в одну аварию, полис ОСАГО будет стоить в два раза меньше обычной цены.

Но не всегда сведения о скидке содержатся в базе РСА, нередки случаи ошибок и упущений, из-за которых водитель лишается бонусов при заключении страхового договора. Это может случиться после замены водительского удостоверения, изменения фамилии, в случае перерыва в страховании больше года, но чаще всего – если страховщик просто не передал ваши данные в базу РСА онлайн.

КБМ после замены ВУ

Нередко после замены водительских прав КБМ возвращается к начальному 3 классу и значению 1, а скидка на ОСАГО обнуляется. Чтобы избежать проблем с получением скидки при продлении страхового полиса, необходимо наличие обновленных данных в базе РСА.

Обновление данных водительского удостоверения требует обращения в страховую компанию и внесения изменений в полис ОСАГО.

Страхователь обязан незамедлительно сообщить в письменной форме страховщику об изменении сведений, указанных в договоре страхования, произошедших в период действия полиса.

Если вы поменяли права или сменили фамилию, необходимо сразу сообщить об этом своему страховому агенту, чтобы он внес изменения в страховой договор и базу РСА. Это касается и случаев изменения личных данных других водителей, вписанных в вашу страховку и допущенных к управлению автомобилем. В случае несвоевременного внесения данных ваша скидка может обнулиться, и для продления полиса придется заново восстанавливать КБМ.

Честный и опытный страховой агент легко решит проблему, если обратит внимание на графу «Особые отметки» и предложит ввести номер предыдущего водительского удостоверения или старую фамилию. Он найдет скидку, сделает новый расчет КБМ и продаст полис ОСАГО по заниженной цене.

Как восстановить КБМ

Если скидка на полис ОСАГО была утрачена, необходимо восстановить КБМ. Первый и самый простой способ восстановить коэффициент бонус-малус: отправить запрос в онлайн базу РСА через специальные сервисы, например, на сайте https://roskbm. ru/. Чтобы восстановить КБМ, зайдите на сайт и следуйте инструкции, по выполнению которой вы сможете вернуть коэффициент к исходному значению.

ru/. Чтобы восстановить КБМ, зайдите на сайт и следуйте инструкции, по выполнению которой вы сможете вернуть коэффициент к исходному значению.

1. В горизонтальном меню главной страницы сайта выберите раздел «Восстановление КБМ за 24 часа» или перейдите по ссылке: https://roskbm.ru/vosstanovit-kbm.

2. Заполните поля заявки: введите ФИО, дату рождения, сведения из старого и текущего водительских удостоверений, в случае смены фамилии не забудьте указать старую фамилию в отдельной графе.

3. После заполнения данных нажмите кнопку «Далее»: через 30 секунд на экране отобразится ваш КБМ и сумма скидки, которую вы должны получить при оплате полиса ОСАГО. В случае загруженности базы РСА, заполните поле с адресом электронной почты – мы направим ответ на запрос туда.

4. Чтобы восстановить КБМ, введите электронную почту и оплатите услугу, после зачисления оплаты запрос на восстановление будет направлен в онлайн базу РСА.

Чтобы восстановить КБМ, введите электронную почту и оплатите услугу, после зачисления оплаты запрос на восстановление будет направлен в онлайн базу РСА.

В письме будет указан номер заявки, по всем вопросам оформления и восстановления КБМ можно обратиться в техподдержку по адресу: [email protected]. После успешной обработки запроса вы получите письмо с результатом восстановления коэффициента, который можно проверить в официальной базе РСА. Мы гарантируем восстановление КБМ, в противном случае вернем деньги за оплату услуги.

Как восстановить КБМ бесплатно

Кроме онлайн обращения в базу РСА, вы можете лично подать заявление на восстановление коэффициента в свою страховую компанию, либо своевременно сообщить об изменении данных водительского удостоверения или гражданского паспорта.

Нередки случаи внесения завышенной оплаты по полису ОСАГО, на которые водитель не обращает внимания. Неправильные расчеты страхового агента, ошибка в базе, спешка или халатное отношение к процедуре переоформления договора страхования становятся причинами неверного применения коэффициента бонус-малус и утраты скидки.

Неправильные расчеты страхового агента, ошибка в базе, спешка или халатное отношение к процедуре переоформления договора страхования становятся причинами неверного применения коэффициента бонус-малус и утраты скидки.

Вы должны выяснить, на каком этапе и когда были внесены ошибочные сведения, для этого достаточно заполнить данные в полях заявки на проверку КБМ и выбрать услугу «История изменения КБМ с 2013 года». Полученные сведения приложите к заявлению и направьте в страховую компанию с требованием произвести перерасчет КБМ и положенной скидки на основании обновленной информации. Не забудьте при наличии приложить дополнительные документы:

- предыдущий полис ОСАГО,

- копии старых и новых водительских прав,

- копию документов, подтверждающих изменение фамилии,

- справку из предыдущей страховой компании об отсутствии выплат по ущербу в ДТП.

Если спустя 10 дней страховщик не рассмотрел заявление, подавайте жалобу в РСА или ЦБ. Жалобу можно подать в простой письменной форме или в электронном виде через заполнение заявки на сайте. Не забудьте:

Жалобу можно подать в простой письменной форме или в электронном виде через заполнение заявки на сайте. Не забудьте:

- Приложить выше названные документы, копию обращения в страховую и ответ на него (при наличии).

- Указать страховую компанию.

- Описать, с каким КБМ ранее оформлялись полисы ОСАГО.

- Обозначить число аварий в период страхования.

Жалоба в РСА или ЦБ рассматривается в течение 60 суток. После восстановления КБМ страховая компания пересчитает стоимость полиса и вернет излишне уплаченные суммы.

Анализ основных компонентов неполных данных — простое решение старой проблемы

Основные моменты

- •

Стандартный алгоритм PCA изменен для учета неполных данных.

- •

Метод позволяет получать оценки ординации для переменных и наблюдений одновременно.

- •

Информация максимально исчерпана, вменение данных не требуется.

- •

Разрешены переменные, которые логически невозможны для определенных наблюдений.

- •

Имеет значение количество переменных, а не процент неизвестных оценок.

Реферат

Давняя проблема анализа биологических данных — непреднамеренное отсутствие значений для некоторых наблюдений или переменных, что препятствует использованию стандартных многомерных исследовательских методов, таких как анализ главных компонент (PCA). Решения включают удаление частей данных, из-за которых информация теряется, вменение данных, которое всегда является произвольным, и ограничение анализа либо переменными, либо наблюдениями, что приводит к потере преимуществ двумерных диаграмм.Мы описываем небольшую модификацию PCA на основе собственного анализа, в которой корреляции или ковариации вычисляются с использованием разного количества наблюдений для каждой пары переменных, а полученные собственные значения и собственные векторы используются для вычисления оценок компонентов, так что пропущенные значения пропускаются. Эта процедура позволяет избежать искусственного вменения данных, исчерпывает всю информацию из данных и позволяет подготовить биплоты для одновременного отображения ординации переменных и наблюдений.Использование модифицированного PCA, называемого InDaPCA (PCA неполных данных), продемонстрировано на реальных биологических примерах: функциональные признаки листьев растений, функциональные признаки беспозвоночных, морфометрия черепа крокодилов и данные гибридизации рыб — с биологически значимыми результатами. Наше исследование показывает, что значение имеет не процент пропущенных записей в матрице данных; На успех InDaPCA в основном влияет минимальное количество наблюдений, доступных для сравнения данной пары переменных.Однако в настоящем исследовании не было препятствий для интерпретации результатов в пространстве первых двух компонентов.

Эта процедура позволяет избежать искусственного вменения данных, исчерпывает всю информацию из данных и позволяет подготовить биплоты для одновременного отображения ординации переменных и наблюдений.Использование модифицированного PCA, называемого InDaPCA (PCA неполных данных), продемонстрировано на реальных биологических примерах: функциональные признаки листьев растений, функциональные признаки беспозвоночных, морфометрия черепа крокодилов и данные гибридизации рыб — с биологически значимыми результатами. Наше исследование показывает, что значение имеет не процент пропущенных записей в матрице данных; На успех InDaPCA в основном влияет минимальное количество наблюдений, доступных для сравнения данной пары переменных.Однако в настоящем исследовании не было препятствий для интерпретации результатов в пространстве первых двух компонентов.

Ключевые слова

Биплот

Корреляция

Функциональный признак

Отсутствующие данные

Морфометрия

Порядок

Аббревиатуры

InDaPCAРекомендуемые статьи

Корреляция

Основные компоненты

Анализ парных данных

© 2021 Автор (ы). Опубликовано Elsevier B.V.

Опубликовано Elsevier B.V.Рекомендуемые статьи

Цитирование статей

Приведение в порядок с помощью PCA: Введение в анализ основных компонентов | Сидней Фирмин

Анализ главных компонентов (PCA) — это метод уменьшения размерности, который представляет собой процесс уменьшения количества переменных-предикторов в наборе данных.

Более конкретно, PCA — это неконтролируемый тип извлечения признаков, при котором исходные переменные объединяются и сокращаются до их наиболее важных и описательных компонентов.

Цель PCA — выявить закономерности в наборе данных, а затем выделить переменные до их наиболее важных характеристик, чтобы упростить данные без потери важных характеристик. PCA спрашивает, вызывают ли радость все измерения набора данных, а затем дает пользователю возможность исключить те, которые этого не делают.

PCA — очень популярный метод, но его часто не понимают люди, применяющие его. Моя цель в этом сообщении в блоге — дать общий обзор того, зачем использовать PCA, а также как это работает.

Проклятие размерности (или зачем беспокоиться об уменьшении размерности?)

Проклятие размерности — это совокупность явлений, которые утверждают, что по мере увеличения размерности, управляемость и эффективность данных имеют тенденцию к снижению . На высоком уровне проклятие размерности связано с тем фактом, что по мере добавления размеров (переменных / характеристик) к набору данных среднее и минимальное расстояние между точками (записями / наблюдениями) увеличивается.

Я считаю, что визуализация переменных в виде измерений и наблюдений в виде записей / точек помогает, когда я начинаю думать о таких темах, как кластеризация или PCA. Каждая переменная в наборе данных представляет собой набор координат для построения наблюдения в проблемном пространстве.

Создание хороших прогнозов становится более трудным, поскольку расстояние между известными точками и неизвестными точками увеличивается. Кроме того, функции в вашем наборе данных могут не добавить большой ценности или предсказательной силы в контексте целевой (независимой) переменной. Эти функции не улучшают модель, скорее они увеличивают шум в наборе данных, а также общую вычислительную нагрузку модели.

Эти функции не улучшают модель, скорее они увеличивают шум в наборе данных, а также общую вычислительную нагрузку модели.

Из-за проклятия размерности уменьшение размерности часто является критическим компонентом аналитических процессов. Особенно в приложениях, где данные имеют высокую размерность, например компьютерное зрение или обработка сигналов.

При сборе данных или применении набора данных не всегда очевидно или легко узнать, какие переменные важны.Нет даже гарантии, что переменные, которые вы выбрали или были предоставлены, являются переменными правильными . Кроме того, в эпоху больших данных огромное количество переменных в наборе данных может выйти из-под контроля и даже сбить с толку и ввести в заблуждение. Это может затруднить (или сделать невозможным) выбор значимых переменных вручную.

Не бойтесь, PCA смотрит на общую структуру непрерывных переменных в наборе данных, чтобы извлечь значимые сигналы из шума в наборе данных.Он направлен на устранение избыточности в переменных при сохранении важной информации.

PCA тоже любит беспорядок.

Как работает PCA

PCA родом из области линейной алгебры. Это метод преобразования, который создает (взвешенные линейные) комбинации исходных переменных в наборе данных с намерением, чтобы новые комбинации улавливали как можно большую дисперсию (т. Е. Разделение между точками) в наборе данных, устраняя при этом корреляции ( я.е., избыточность).

PCA создает новые переменные путем преобразования исходных (центрированных по среднему) наблюдений (записей) в наборе данных в новый набор переменных (измерений) с использованием собственных векторов и собственных значений, вычисленных из ковариационной матрицы исходных переменных.

Это полный рот. Давайте разберемся с этим, начав со среднего значения исходных переменных.

Первым шагом PCA является центрирование значений всех входных переменных (например, вычитание среднего значения каждой переменной из значений), при котором среднее значение каждой переменной становится равным нулю. Центрирование является важным этапом предварительной обработки, поскольку оно гарантирует, что результирующие компоненты смотрят только на дисперсию в наборе данных, а не фиксируют общее среднее значение набора данных в качестве важной переменной (измерения). Без центрирования среднего первый главный компонент, найденный PCA, мог бы соответствовать среднему значению данных, а не направлению максимальной дисперсии.

Центрирование является важным этапом предварительной обработки, поскольку оно гарантирует, что результирующие компоненты смотрят только на дисперсию в наборе данных, а не фиксируют общее среднее значение набора данных в качестве важной переменной (измерения). Без центрирования среднего первый главный компонент, найденный PCA, мог бы соответствовать среднему значению данных, а не направлению максимальной дисперсии.

После того, как данные центрированы (и, возможно, масштабированы, в зависимости от единиц переменных), необходимо вычислить ковариационную матрицу данных.

Ковариация измеряется между двумя переменными (измерениями) одновременно и описывает, как значения переменных связаны друг с другом: например, поскольку наблюдаемые значения увеличения переменной x одинаковы для переменной y? Большое значение ковариации (положительное или отрицательное) указывает на то, что переменные имеют сильную линейную связь друг с другом. Значения ковариации, близкие к 0, указывают на слабую или несуществующую линейную связь.

Эта визуализация из https: // stats.stackexchange.com/questions/18058/how-would-you-explain-covariance-to-someone-who-understands-only-the-mean очень полезен для понимания ковариации.

Ковариация всегда измеряется в двух измерениях. Если вы имеете дело с более чем двумя переменными, наиболее эффективный способ убедиться, что вы получили все возможные значения ковариации, — это поместить их в матрицу (следовательно, матрицу ковариации). В ковариационной матрице диагональ — это дисперсия для каждой переменной, а значения по диагонали являются зеркалом друг для друга, потому что каждая комбинация переменных включается в матрицу дважды.Это квадратная симметричная матрица.

В этом примере дисперсия переменной A составляет 0,67, а дисперсия второй переменной — 0,25. Ковариация между двумя переменными составляет 0,55, что отражается на главной диагонали матрицы.

Поскольку ковариационные матрицы квадратные и симметричные, их можно диагонализовать, что означает, что для матрицы можно вычислить собственное разложение. Здесь PCA находит собственные векторы и собственные значения для набора данных.

Здесь PCA находит собственные векторы и собственные значения для набора данных.

Собственный вектор линейного преобразования — это (ненулевой) вектор, который изменяется на скалярное кратное самому себе, когда к нему применяется соответствующее линейное преобразование.Собственное значение — это скаляр, связанный с собственным вектором. Самая полезная вещь, которую я нашел для понимания собственных векторов и значений, — это увидеть пример (если это не имеет смысла, попробуйте посмотреть этот урок умножения матриц от Khan Acadamy).

Мне сказали, что использование * для умножения матриц — это необычное явление, но я оставил его для ясности. Приношу свои извинения любому оскорбленному математику, читающему это.

В этом примере

— это собственный вектор, а 5 — собственное значение.

В контексте понимания PCA на высоком уровне все, что вам на самом деле нужно знать о собственных векторах и собственных значениях, — это то, что собственные векторы ковариационной матрицы являются осями основных компонентов в наборе данных. Собственные векторы определяют направления главных компонентов, вычисляемых с помощью PCA. Собственные значения, связанные с собственными векторами, описывают величину собственного вектора или насколько далеко разнесены наблюдения (точки) вдоль новой оси.

Собственные векторы определяют направления главных компонентов, вычисляемых с помощью PCA. Собственные значения, связанные с собственными векторами, описывают величину собственного вектора или насколько далеко разнесены наблюдения (точки) вдоль новой оси.

Первый собственный вектор будет охватывать наибольшую дисперсию (разделение между точками), обнаруженную в наборе данных, а все последующие собственные векторы будут перпендикулярны (или, говоря математическим языком, ортогональны) к вычисленному перед ним.Вот как мы можем узнать, что каждый из основных компонентов не будет коррелирован друг с другом.

Если вы хотите узнать больше о собственных векторах и собственных значениях, в Интернете есть множество ресурсов, разбросанных именно с этой целью. Для краткости я не буду пытаться преподавать линейную алгебру (плохо) в сообщениях в блоге.

Каждый собственный вектор, найденный PCA, выбирает комбинацию отклонений от исходных переменных в наборе данных.

На этом рисунке Главный компонент 1 учитывает отклонения от обеих переменных A и B.

Собственные значения важны, потому что они обеспечивают критерий ранжирования для вновь полученных переменных (осей). Основные компоненты (собственные векторы) сортируются по убыванию собственного значения. Главные компоненты с наивысшими собственными значениями «выбираются первыми» как главные компоненты, поскольку они составляют наибольшую дисперсию данных.

Вы можете указать, что возвращает почти столько основных компонентов, сколько переменных в исходном наборе данных (обычно до n-1, где n — количество исходных входных переменных), но большая часть дисперсии будет учтена в главные основные компоненты.Чтобы узнать, сколько основных компонентов выбрать, ознакомьтесь с этим обсуждением переполнения стека. Или вы всегда можете просто спросить себя: «Я, сколько измерений вызовет радость?» (Это была шутка, вам, вероятно, следует просто использовать график осыпи.)

График осыпи показывает дисперсию, зафиксированную каждым главным компонентом. Этот график Scree был создан для вывода отчета инструмента «Основные компоненты» в Alteryx Designer.

После определения основных компонентов набора данных наблюдения исходного набора данных необходимо преобразовать в выбранные основные компоненты.

Чтобы преобразовать наши исходные точки, мы создаем матрицу проекции. Эта матрица проекции — это просто выбранные собственные векторы, объединенные в матрицу. Затем мы можем умножить матрицу наших исходных наблюдений и переменных на нашу матрицу проекции. Результатом этого процесса является преобразованный набор данных, проецируемый в наше новое пространство данных, состоящий из наших основных компонентов!

Вот и все! Мы завершили СПС.

Допущения и ограничения

Перед применением PCA необходимо учесть несколько моментов.

Нормализация данных перед выполнением PCA может быть важной, особенно когда переменные имеют разные единицы или масштабы. Вы можете сделать это в инструменте «Дизайнер», выбрав опцию Масштабировать каждое поле, чтобы иметь отклонение единиц измерения.

PCA предполагает, что данные могут быть аппроксимированы линейной структурой и что данные могут быть описаны с меньшим количеством функций. Он предполагает, что линейное преобразование может и будет захватывать наиболее важные аспекты данных. Также предполагается, что высокая дисперсия данных означает высокое отношение сигнал / шум.

Уменьшение размерности действительно приводит к потере некоторой информации. Из-за того, что не сохраняются все собственные векторы, некоторая информация теряется. Однако, если собственные значения собственных векторов, которые не включены, малы, вы не теряете слишком много информации.

Еще одно соображение, которое следует учитывать при использовании PCA, заключается в том, что переменные становятся менее интерпретируемыми после преобразования. Входная переменная может означать что-то конкретное, например, «воздействие УФ-излучения», но переменные, созданные PCA, представляют собой беспорядочную смесь исходных данных и не могут быть интерпретированы однозначно, например, «увеличение воздействия УФ-излучения коррелирует с увеличением наличие рака кожи.«Менее интерпретируемый также означает менее объяснимый, когда вы предлагаете свои модели другим.

Сильные стороны

PCA популярен, потому что он может эффективно находить оптимальное представление набора данных с меньшим количеством измерений. Он эффективен при фильтрации шума и уменьшении избыточности. Если у вас есть набор данных с множеством непрерывных переменных, и вы не знаете, как выбрать важные функции для целевой переменной, PCA может идеально подойти для вашего приложения.Аналогичным образом, PCA также популярен для визуализации наборов данных с высокой размерностью (потому что нам, скудным людям, трудно мыслить более чем в трех измерениях).

Дополнительные ресурсы

Мой любимый учебник (который включает в себя обзор лежащих в основе математики) принадлежит Линдси И. Смит из Университета Отаго. Учебник по анализу основных компонентов.

Вот еще один отличный учебник по анализу основных компонентов от Джона Шленса из UCSD

Все, что вы знали и не знали о PCA, из блога Its Neuronal посвящено математике и вычислениям в нейробиологии.

«Анализ главных компонентов за 3 простых шага» имеет несколько хороших иллюстраций и разбит на отдельные шаги.

«Анализ основных компонентов» из блога Джереми Куна — это приятная лаконичная статья, в которой есть ссылка на собственные лица.

Универсальный центр анализа основных компонентов от Мэтта Бремса.

Оригинал. Размещено с разрешения.

Как, где и когда следует использовать PCA | by Bartosz Szabłowski

Давайте рассчитаем ковариационную матрицу для нашего набора данных:

array ([[1.01010101, 0,97727597, -0,01747925, -0,04152546],

[0,97727597, 1,01010101, -0,039, -0,06169213],

[-0,01747925, -0,039, 1,01010101, 0,87546278] -01075139 -01516278] )

3. Собственное разложение.

· Собственные векторы ➞ направления PCA

· Собственные значения ➞ важность направлений

Ковариационная матрица симметрична, а собственные векторы симметричных матриц ортогональны. Таким образом, первый главный компонент объясняет большую часть дисперсии.Ортогонален ему второй главный компонент, который объясняет большую часть оставшейся дисперсии и так далее. Теперь пора выполнить разложение ковариационной матрицы.

собственные значения: [2.0243665 1,87865542 0,03358615 0,10379597]собственные векторы:

[[-0,62202904 -0,33364184 -0,69970849 -0,11032236]

[-0,6031108 -0,36974369 0,70534377 0,04513474]

[-0,32423873 0,63027923 0,09785443 -0,69859992]

[-0,37974529 0.59558444 - 0,05764294 0,70551399]]

Мы получили вектор (собственные значения), состоящий из 4 собственных значений и матрицы 4 × 4, хранящей собственные векторы.

4. Объяснение общей дисперсии.

Цель PCA — уменьшить количество измерений. Мы сжимаем текущие функции в новые функции, которые являются собственными векторами (главными компонентами), содержащими наибольшее количество информации. Информация эквивалентна дисперсии. Собственные значения — это размер собственных векторов. Следовательно, их следует расположить в порядке убывания. Объясняемый процент дисперсии — это собственное значение, деленное на общую сумму всех собственных значений. Исходя из этого, мы можем вычислить процент объясненной дисперсии для каждого главного компонента нашего набора:

[0.501, 0,465, 0,026, 0,008]

Как мы видим, сумма первых двух основных компонентов составляет более 95% дисперсии.

5. Преобразование признаков.

Мы преобразуем наш 4-мерный набор данных в сжатый 2-мерный набор данных. Используя первые два собственных вектора, мы создадим матрицу проекции и будем использовать ее для перемещения нашего набора данных в подпространство, состоящее из двух измерений.

Мы создаем пару кортежей собственных значений и собственных векторов, а затем сортируем их по убыванию собственных значений.Мы выбираем первые два собственных вектора, на которые приходится около 95% дисперсии. Мы создали матрицу проекции w , на которую мы перенесли наблюдения из набора данных. Наконец, мы визуализируем преобразованный набор данных.

Визуализация работы PCA, изображение автораПриведенный выше пример демонстрирует алгоритм PCA [ 3 ]. Теперь перейдем к практическому применению.

Мы больше не будем выполнять все шаги из алгоритма PCA, мы будем использовать его реализацию в scikit-learn.Мы познакомимся с популярным набором данных iris и посмотрим, поможет ли PCA улучшить классификацию.

Давайте загрузим данные и посмотрим первые 5 и последние 5 строк:

+ ----- + ----------- + ----------- + - ---------- + ----------- + ----------- +

| | sep_len | sep_wid | pet_len | pet_wid | виды |

| ----- + ----------- + ----------- + ----------- + ------ ----- + ----------- |

| 0 | 5.1 | 3.5 | 1.4 | 0,2 | сетоса |

| 1 | 4.9 | 3 | 1.4 | 0,2 | сетоса |

| 2 | 4.7 | 3.2 | 1.3 | 0,2 | сетоса |

| 3 | 4.6 | 3.1 | 1.5 | 0,2 | сетоса |

| 4 | 5 | 3.6 | 1.4 | 0,2 | сетоса |

| 145 | 6,7 | 3 | 5.2 | 2.3 | вирджиника |

| 146 | 6.3 | 2,5 | 5 | 1.9 | вирджиника |

| 147 | 6.5 | 3 | 5.2 | 2 | вирджиника |

| 148 | 6.2 | 3.4 | 5.4 | 2.3 | вирджиника |

| 149 | 5,9 | 3 | 5.1 | 1.8 | вирджиника |

+ ----- + ----------- + ----------- + ----------- + ------ ----- + ----------- +

Как видите, у нас есть четыре измерения, и каждому цветку присвоено название вида (вид в столбце). Всего цветов в базе 150. Давайте посчитаем базовую статистику для нашего набора данных:

+ ------- + ------------ + -------- ---- + ----------- + ------------ +

| | sep_len | sep_wid | pet_len | pet_wid |

| ------- + ------------ + ------------ + ----------- + - ---------- |

| счет | 150 | 150 | 150 | 150 |

| означает | 5.84333 | 3.05733 | 3.758 | 1.19933 |

| std | 0.828066 | 0.435866 | 1.7653 | 0.762238 |

| мин | 4.3 | 2 | 1 | 0,1 |

| 25% | 5.1 | 2,8 | 1.6 | 0,3 |

| 50% | 5.8 | 3 | 4.35 | 1.3 |

| 75% | 6.4 | 3.3 | 5.1 | 1.8 |

| макс | 7,9 | 4.4 | 6.9 | 2,5 |

+ ------- + ------------ + ------------ + ----------- + - ---------- +

virginica 50

setosa 50

versicolor 50

Имя: разновидности, dtype: int64

Конечно, в реальном проекте Data Science на этом этапе интеллектуальный анализ данных не должен заканчиваться, но в этой статье главный герой — PCA.Давайте попробуем визуализировать наши данные:

Визуализация набора данных Iris, изображение автора· Избавление от «избыточных» данных (коррелированные переменные)

Некоторые переменные несут схожую информацию. Посмотрим, так ли это в наших данных.

Pairplot, Image by AuthorКак видите, некоторые переменные коррелируют друг с другом, в первую очередь длина лепестка и ширина лепестка. Оба они также коррелируют с длиной чашелистника. Наименее полезной кажется ширина чашелистника. Можно сделать вывод, что с помощью только одной переменной разделить классы несложно, еще проще разделить классы по парам переменных.Теперь давайте проверим корреляции:

Коррелограмма набора данных радужки, изображение автораНаша предыдущая гипотеза подтвердилась, переменные длина чашелистика, длина лепестка и ширина лепестка сильно коррелированы друг с другом. В некоторых моделях машинного обучения коррелированные переменные ухудшают результат, поскольку они придают больший вес одному фрагменту информации. Пришло время применить PCA, но мы не сможем сделать это для всего набора данных, если позже построим модель для классификации видов. Если бы мы применили PCA ко всему набору данных, произошла бы утечка информации.Давайте создадим фрейм данных X, содержащий функции и вектор меток y, а затем разделим данные на обучающие и тестовые данные. Мы должны стандартизировать наш обучающий набор, как я писал ранее. Среднее значение будет равно 0 для каждой переменной, и данные будут в той же шкале — стандартное отклонение. После этой операции мы можем выполнить PCA на нашем наборе.

В обучающей выборке 100 строк.

Тестовый набор состоит из 50 рядов.

+ ----- + -------------- + ------------- + ------------- - + -------------- +

| | PC1 | PC2 | PC3 | PC4 |

| ----- + -------------- + ------------- + ------------- - + -------------- |

| PC1 | 1 | 6.45038e-17 | 2.13745e-17 | -4.80269e-17 |

| PC2 | 6.45038e-17 | 1 | 6.07219e-17 | 1.28115e-17 |

| PC3 | 2.13745e-17 | 6.07219e-17 | 1 | -5.57337e-17 |

| PC4 | -4.80269e-17 | 1.28115e-17 | -5.57337e-17 | 1 |

+ ----- + -------------- + ------------- + ------------- - + -------------- +

Как мы видим, переменные больше не коррелированы.

· Группировка признаков (функции представляют собой один фрагмент информации)

В некотором смысле это продолжение предыдущего раздела, поскольку коррелированные переменные несут одну часть информации.PCA — это не алгоритм, который объединяет наблюдения в кластеры, но вместо этого он может определить, какие функции в наименьшей степени способствуют объяснению структуры компонентов. Давайте теперь создадим распределение функций по компонентам. Чем больше вклад исходного элемента в компонент, тем темнее его цвет на графике.

Распределение функций по основным компонентам, изображение автораОтлично! Подтверждаем то, о чем вы читали ранее. Первый главный компонент был создан из коррелированных переменных.Второй главный компонент интересен тем, что мы не обнаружили значимой корреляции между длиной чашелистника и его шириной. Интересный.

· Уменьшение размеров без значительной потери информации

Объясненный график дисперсии показывает, сколько информации содержится в каждом основном компоненте. Мы можем использовать метод локтя, известный как выбор гиперпараметров в других моделях машинного обучения, чтобы выбрать подходящее количество компонентов. Еще одна форма визуализации — совокупный график.

Объясненная дисперсия и Кумулятивная объясненная дисперсия, Изображение автора+ ----------- + ---------------------- + - ----------------------------- +

| Компонент | Объясненное отклонение | Кумулятивная объясненная дисперсия |

+ ----------- + ---------------------- + ------------- ------------------ +

| 1 | 0.712014337051845000 | 0.7120143370518450 |

| 2 | 0.2396536428780 | 0.9516679799429029 |

| 3 | 0.043160458797882550 | 0.9948284387407854 |

| 4 | 0.005171561259214621 | 1.0000000000000000 |

+ ----------- + ---------------------- + ------------- ------------------ +

График показывает, что отклонение данных на 95% объясняется двумя компонентами.

· Визуализация многомерных данных

Мы живем в трехмерной реальности. Наш мозг очень хорошо это понимает. Однако все, что выходит за рамки трех измерений, нам обычно очень трудно представить.Используя методы уменьшения размерности, мы можем «сгладить» количество измерений нашего набора данных радужки и визуализировать его в двухмерном пространстве. В следующем примере представлена эта визуализация. Цвета точек на графике указывают на вид вида.

Как мы видим, сетоса хорошо отделена от других классов. Virginica и Versicolor имеют нечеткую границу, которая при разделении этих классов может снизить точность, но я не ошибаюсь, глядя на это двумерное представление данных.

· Часть процесса контролируемого обучения

Мы можем с уверенностью сказать, что 4-я промышленная революция — это время данных, которые нас окружают. Мы можем использовать PCA для сжатия данных, сделав наши алгоритмы машинного обучения «быстрее» и уменьшив набор данных. Меньшее количество входных переменных может привести к более простой модели прогнозирования, которая может иметь лучшую производительность при прогнозировании новых данных. Пришло время обучить нашу модель на обучающем наборе и проверить ее возможности на тестовом наборе. Применим логистическую регрессию! Мы обучим модель на исходном наборе, последовательно на стандартизированном наборе и всех основных компонентах.

+ ------------------------ + ---------- + ----------- ------------------- +

| Модель | Точность | Время обучения (микросекунды) |

+ ------------------------ + ---------- + ------------ ------------------ +

| немасштабированные данные | 1.0 | 48403 |

| масштабированные данные | 0,98 | 8973 |

| 4 основных компонента | 0,98 | 8977 |

| 3 основных компонента | 0,98 | 8008 |

| 2 основных компонента | 0.94 | 5985 |

| 1 Основные компоненты | 0,92 | 5983 |

+ ------------------------ + ---------- + ------------ ------------------ +

Набор данных Iris довольно мал по стандартам машинного обучения. Таким образом, разница в точности между 1,00 и 0,98 на тестовой выборке незначительна. Мы видим, что использование стандартизации оказывает большое влияние на время изучения модели. Если бы я внедрил модель в производство, это было бы 3 основных компонента, поскольку она уже имеет уменьшенную размерность, которая объясняет 0.99 дисперсии.

В этой статье я обсуждал применение PCA для уменьшения размерности, визуализации многомерных данных и его использование в обучении с учителем. Метод PCA может применяться только к числовым данным, как для анализа исходных данных, так и для уменьшения признаков (размеров). Это может помочь получить первые приблизительные очертания закономерностей, лежащих в основе данного явления. Он основан на корреляции, которая может вводить в заблуждение (помните: корреляция не подразумевает причинно-следственную связь!).Я надеюсь, что уменьшение размерности с помощью анализа главных компонентов теперь стало для вас более ясным. Другие используемые методы уменьшения размерности:

· ICA

· LLE

· ISOMAP

· t-SNE

. Если вам нужно что-то еще в этой статье, дайте мне знать, я отредактирую ее или вы хотите, чтобы я написал статью о конкретном алгоритме, дайте мне знать.

[ 1 ] Дж. Джеймс, Д. Виттен, Т. Хасти, Р. Тибширани, Введение в статистическое обучение: с приложениями в R (2013)

[ 2 ] A.Герон, Практическое машинное обучение с помощью Scikit ‑ Learn, Keras и TensorFlow (2017), O’Reilly Media

[ 3 ] С. Рашка, В. Мирджалили, Машинное обучение Python: машинное обучение и глубокое обучение с помощью Python , scikit-learn и TensorFlow 2, 2-е издание (2017 г.), Packt Publishing

обзор и последние разработки

(a) Анализ основных компонентов как исследовательский инструмент для анализа данных

Стандартный контекст для PCA как исследовательских данных инструмент анализа включает набор данных с наблюдениями на p числовых переменных для каждого из n юридических или физических лиц.Эти значения данных определяют p n -мерные векторы x 1 ,…, x p или, что то же самое, матрица данных n × p X , чей столбец j является вектором x j наблюдений над переменной j th. Ищем линейную комбинацию столбцов матрицы X с максимальной дисперсией. Такие линейные комбинации задаются формулой, где a — вектор констант a 1 , a 2 ,…, a p .Дисперсия любой такой линейной комбинации определяется как var ( X a ) = a ‘ S a , где S — это выборочная ковариационная матрица, связанная с набором данных, а’ обозначает транспонирование. Следовательно, определение линейной комбинации с максимальной дисперсией эквивалентно получению p -мерного вектора a , который максимизирует квадратичную форму a ‘ S a . Чтобы эта проблема имела четко определенное решение, необходимо наложить дополнительное ограничение, и наиболее распространенное ограничение связано с работой с векторами единичной нормы, т.е.е. требуя a ′ a = 1. Задача эквивалентна максимизации a ′ S a — λ ( a ′ a −1), где λ — множитель Лагранжа. Дифференцирование относительно вектора a и приравнивание к нулевому вектору дает уравнение

2,1

Таким образом, a должен быть (единичная норма) собственным вектором, а λ — соответствующим собственным значением ковариационной матрицы S .В частности, нас интересует наибольшее собственное значение , λ 1 (и соответствующий собственный вектор a 1 ), поскольку собственные значения представляют собой дисперсии линейных комбинаций, определяемых соответствующим собственным вектором a : var ( X a ) = a ′ S a = λ a ′ a = λ . Уравнение (2.1) остается в силе, если собственные векторы умножаются на -1, и поэтому знаки всех нагрузок (и оценок) являются произвольными, и только их относительные величины и образцы знаков имеют смысл.

Любая p × p вещественная симметричная матрица, такая как ковариационная матрица S , имеет ровно p вещественных собственных значений, λ k ( k = 1,…, p ), и их соответствующие собственные векторы могут быть определены для формирования ортонормированного набора векторов, то есть a ′ k a k ′ = 1, если k = k ′ и ноль иначе. Подход с использованием множителей Лагранжа с дополнительными ограничениями на ортогональность различных векторов коэффициентов также можно использовать, чтобы показать, что полный набор собственных векторов S является решением проблемы получения до p новых линейных комбинаций, которые последовательно максимизировать дисперсию с учетом некоррелированности с предыдущими линейными комбинациями [4].Некоррелированность возникает из-за того, что ковариация между двумя такими линейными комбинациями, X a k и X a k ′ , определяется как a ′ k ′ S a k = λ k a ′ k ′ a k = 0, если k ′ ≠ k .

Именно эти линейные комбинации X a k называются главными компонентами набора данных, хотя некоторые авторы по ошибке также используют термин «главные компоненты», когда ссылаются на собственные векторы a . к . В стандартной терминологии PCA элементы собственных векторов a k обычно называются загрузками ПК , тогда как элементы линейных комбинаций X a k называются ПК. набирает , так как это значения, которые каждый человек мог бы получить на данном ПК.

В стандартном подходе принято определять ПК как линейные комбинации центрированных переменных x * j , с общим элементом, где обозначает среднее значение наблюдений для переменной j . Это соглашение не меняет решения (кроме центрирования), поскольку ковариационная матрица набора центрированных или нецентрированных переменных одинакова, но имеет то преимущество, что обеспечивает прямую связь с альтернативным, более геометрическим подходом к PCA.

Обозначив X * матрицу n × p , столбцы которой являются центрированными переменными x * j , мы имеем

2,2

Уравнение (2.2) связывает собственное разложение ковариационной матрицы S с разложением по сингулярным значениям матрицы данных с центром по столбцам X *. Любая произвольная матрица Y размерности n × p и ранга r (обязательно) может быть записана (e.г. [4]) как

2.3

где U , A — это матрицы n × r и p × r с ортонормированными столбцами ( U ′ U = I r = A ′ A , с I r единичная матрица r × r ) и L — это диагональная матрица r × r . Столбцы A называются правыми сингулярными векторами Y и являются собственными векторами матрицы p × p Y ‘ Y , связанной с ее ненулевыми собственными значениями.Столбцы U называются левыми сингулярными векторами Y и являются собственными векторами матрицы n × n Y Y ‘, которые соответствуют ее ненулевым собственным значениям. Диагональные элементы матрицы L называются сингулярными значениями Y и являются неотрицательными квадратными корнями из (общих) ненулевых собственных значений как матрицы Y ′ Y , так и матрицы Y Y ′. Мы предполагаем, что диагональные элементы L расположены в порядке убывания, и это однозначно определяет порядок столбцов U и A (за исключением случая одинаковых сингулярных значений [4]).Следовательно, принимая Y = X *, правые сингулярные векторы матрицы данных с центром в столбцах X * являются векторами a k загрузок ПК. Из-за ортогональности столбцов A , столбцы матричного продукта X * A = ULA ′ A = UL являются ПК X *. Дисперсии этих ПК представлены квадратами сингулярных значений X *, деленных на n -1.Эквивалентно, учитывая (2.2) и указанные выше свойства,

2,4

, где L 2 — диагональная матрица с возведенными в квадрат сингулярными значениями (т. Е. Собственными значениями ( n -1) S ). Уравнение (2.4) дает спектральное разложение или собственное разложение матрицы ( n -1) S . Следовательно, PCA эквивалентен SVD матрицы данных с центром по столбцам X *.

Свойства SVD предполагают интересные геометрические интерпретации PCA.Для любого ранга r матрица Y размером n × p , матрица Y q того же размера, но ранга q < r , элементы которой минимизируют сумма квадратов разностей с соответствующими элементами Y дается [7] как

2,5

где L q — диагональная матрица q × q с первым (наибольшим) q диагональные элементы L и U q , A q — это матрицы n × q и p × q , полученные путем сохранения соответствующих столбцов q в U и A .

В нашем контексте n строк ранга r столбцовой матрицы данных X * определяют диаграмму рассеяния n точек в r -мерном подпространстве, с центром в центре силы тяжести диаграммы рассеяния. Приведенный выше результат подразумевает, что « наилучшее » приближение n точек к этой диаграмме рассеяния в подпространстве размерности q задается строками X * q , определенными как в уравнении (2 .5), где «лучший» означает, что сумма квадратов расстояний между соответствующими точками на каждой диаграмме рассеяния минимизирована, как в оригинальном подходе Пирсона [1]. Система осей q в этом представлении задается первыми ПК q и определяет главное подпространство . Следовательно, PCA — это, по сути, метод уменьшения размерности, посредством которого набор исходных переменных p может быть заменен оптимальным набором производных переменных q , ПК.Когда q = 2 или q = 3, возможна графическая аппроксимация диаграммы рассеяния n точек, которая часто используется для начального визуального представления полного набора данных. Важно отметить, что этот результат является инкрементным (следовательно, адаптивным) по своим размерам в том смысле, что лучшее подпространство размерности q +1 получается путем добавления дополнительного столбца координат к тем, которые определяли наилучшие q -мерное решение.

Качество любой аппроксимации размеров q можно измерить по изменчивости, связанной с набором сохраненных ПК.Фактически, сумма дисперсий исходных переменных p является следом (суммой диагональных элементов) ковариационной матрицы S . Используя результаты простой теории матриц, легко показать, что это значение также является суммой дисперсий всех p ПК. Следовательно, стандартным показателем качества данного ПК является доля от общей дисперсии , которую он составляет,

2,6

где tr ( S ) обозначает след S .Инкрементальный характер ПК также означает, что мы можем говорить о доле общей дисперсии, объясняемой набором ПК (обычно, но не обязательно, первые на ПК), которая часто выражается как процента от общей дисперсии. приходилось: .